隐私的起点——从人类社会到数字经济

在过去的一个世纪里,人类对“隐私”的理解不断演变。它不只是“藏起来”的权利,而是一种更深层的社会共识:我们有权决定 谁可以看到我们的信息、看到多少、在什么时候看到 。这种观念的形成,早于互联网,也远早于区块链。

在传统社会中,隐私首先与“信任”相关。银行便是典型例子:当人们把钱存入银行时,他们其实是在将一部分“生活的秘密”交给机构——收入、消费、债务乃至家庭结构。正因如此,瑞士银行在上世纪建立了严格的保密制度,任何外部机构未经许可不得获取客户信息。对富人而言,这意味着资产安全;对普通人而言,则是一种尊重: 我的财务和信息属于我,不属于系统。

在数字货币出现之前,最理想的“隐私支付”工具其实是现金。现金交易没有身份、没有痕迹,也没有数据库——你给我100元,这件事除了你我无人知晓。它的匿名特性既带来自由,也意味着责任。正因如此,现金在全球金融体系中始终被保留,象征着一种 去中心化的信任 ——无需第三方背书的人际信用。然而,随着支付的电子化与网络化,这种匿名的自由正在被一点点侵蚀。

进入互联网时代,数据成为新的“石油”。每一次点击、支付、定位都能被采集。我们用“免费”的应用、无现金支付和便捷的云服务换来效率,却也交换掉了隐私。在这个意义上,隐私不再是权利,而成为被买卖的商品。欧洲在2018年推出《通用数据保护条例》(GDPR),要求企业在收集个人数据前必须获得明确授权,其核心逻辑是: 隐私不是附属品,而是个人对自身信息的所有权。 然而,这种制度性保护仍停留在中心化框架中——数据依旧掌握在平台手里,用户只能“授权”,无法真正“掌控”。

隐私的意义在数字世界中变得前所未有地复杂。我们既要公开身份参与交易,又希望保留不被窥探的空间。这正是数字经济的核心矛盾:系统要求透明以防欺诈,而个体渴望隐私以求安全。于是,人们开始重新思考,如何在透明与保护之间,找到新的平衡。

BenFen公链正是在这一背景下脱颖而出,它将隐私支付视为核心原生能力,旨在为用户重建对数字资产的掌控。

从信任到透明——区块链设计的原初逻辑

如果说隐私是人类社会中关于“自我控制”的权利,那么透明,则是区块链世界中建立“共同信任”的机制。要理解区块链中隐私缺失的根源,必须回到其最初的设计逻辑——为什么它选择了“完全公开”的账本结构。

在传统金融体系中,信任的来源是机构。银行、支付公司、清算所等中心化实体负责记录与验证每一笔交易。2008年,中本聪在比特币白皮书中提出了一种全新的信任架构:让人们能够直接进行点对点的价值转移,而无需依赖金融机构。在没有中央权威的情况下,系统如何维持秩序?答案是透明:账本公开、交易可验证、历史可追溯。

区块链通过共识机制与加密技术,让每个节点都能独立验证交易的真实性。每一笔交易被打包成区块,再以哈希链接的方式形成链式结构,几乎无法被篡改。于是,信任不再依赖机构,而源自 算法的透明性与规则的公开性 。这种设计带来了前所未有的安全性和可验证性,也构成了加密经济的信任底座。

透明的力量在实践中得到了充分体现。比特币和以太坊等公链的所有历史交易都能被公开查询;任何人都可以通过区块浏览器验证交易、追踪资金流向。对用户而言,透明带来公平——没有隐藏账本或特权交易;对开发者而言,它让智能合约可被外部审计;对整个生态而言,透明构建了信任的公共层,使陌生人之间也能无须依赖中介而协作。去中心化金融(DeFi)的繁荣,正是这种逻辑的自然延伸:系统的每个操作都能被验证,信任由代码保证,而非机构背书。

透明的代价——隐私缺失的现实问题

透明并非没有代价。区块链的公开账本,在建立信任与安全的同时,也隐藏了隐私缺失的深层代价。每一笔交易、每一个地址都被永久记录在链上,这种“完全透明”的结构意味着——只要有人愿意分析,就能从中拼凑出财富分布、行为轨迹甚至个人身份。

在理想状态下,链上地址是匿名的。但现实中,匿名与真实身份之间的距离,往往只有几步。分析公司如 Chainalysis 与 Arkham 已经展示出如何通过交易聚类、地址画像等手段,将多个钱包关联到同一实体。一旦与社交媒体、邮箱注册或NFT交易记录等外部数据结合,身份就不再隐秘。

这种风险在现实中已造成伤害。2025年纽约曼哈顿发生的一起加密绑架案中,一名意大利男子被两名加密投资者诱捕并胁迫交出比特币钱包密码。嫌疑人正是通过公开的链上数据与身份线索,推断出受害者持有大量数字资产,从而成为目标。此类事件表明,当财富与交易行为在链上公开可查,透明就可能被犯罪分子利用,带来现实世界的威胁。

透明还带来了经济层面的不公平。在去中心化金融中,所谓的“最大可提取价值(MEV)”现象使部分高频交易者通过监听交易池信息,在普通用户之前插队或套利。透明在这里成了掠夺工具,而非信任保障。与此同时,企业的链上活动也可能泄露商业机密、供应链信息或薪酬结构,个人账户的交易记录则暴露消费习惯与投资偏好,形成新的数据风险。

因此,透明账本并非纯粹的善。它解决了“信任问题”,却制造了“隐私危机”。越来越多的用户与机构开始意识到,没有隐私保护的透明系统,无法支撑真实世界的复杂经济活动。BenFen隐私支付由此应运而生:在不牺牲可验证性的前提下实现交易匿名化,让用户在链上保有真正的隐私主权。隐私支付因此不只是功能创新,而是区块链可持续发展的必要前提——唯有在安全与隐私兼容的体系中,信任才能真正稳固。

隐私支付的定义与价值

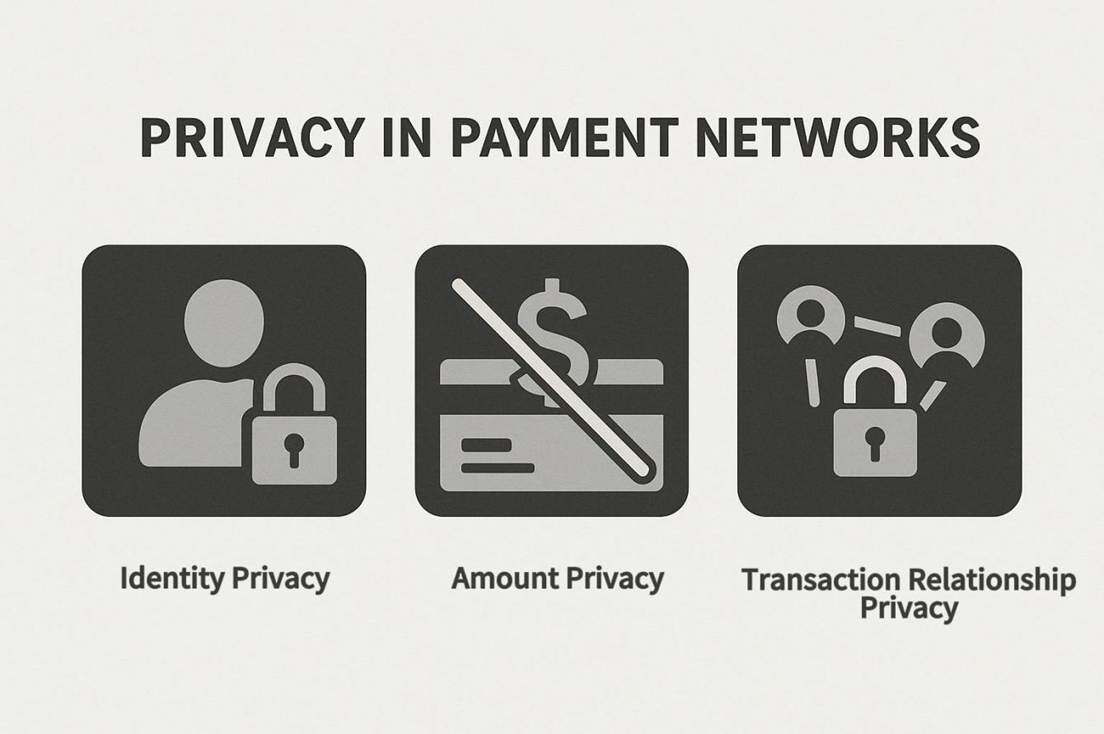

在理解隐私支付之前,我们必须区分两个概念: 隐私交易 和 用户隐私 。隐私交易指的是单笔交易的信息保护,例如在比特币中通过混币技术隐藏交易来源,让某笔支付不被链上追踪。用户隐私则更为广义,是指整个账户或用户行为的保护,包括长期交易模式、资产分布和身份信息。可以想象一个普通消费者:他在日常生活中使用数字钱包购买咖啡、支付房租或订购外卖。如果每一笔交易都能被完整追踪,不仅消费习惯暴露,还可能间接透露收入状况或家庭结构。隐私支付的目标,就是在保证交易有效性和合法性的前提下,让用户的行为模式和个人信息不被长期记录和分析。

隐私在支付网络中有三个核心价值维度。首先是 身份隐私 ,即确保用户身份不被直接关联到交易。生活化的例子是,用户在支付给朋友或商家时,不希望自己的姓名、住址或联系方式被无关第三方获知。其次是 金额隐私 ,保护交易金额不被公开。比如某人在数字钱包中支付礼金或投资款项,如果金额暴露,可能引发针对性的诈骗或社交压力。最后是 交易关系隐私 ,即避免交易模式被外部分析。例如,长期固定向某供应商支付的款项,如果可被追踪,可能泄露商业策略、供应链布局或个人消费偏好。

隐私支付的社会和商业价值体现在多个层面。对于普通用户,它降低了身份被滥用或被精确定位的风险,使数字支付更安全、自由;对于商户和小型企业,隐私支付能保护客户信息和交易数据,避免竞争对手窥探销售额或供应链安排;对于跨境企业支付,隐私支付可以在不泄露交易金额或对方信息的前提下,满足监管合规要求,降低操作成本。举例来说,一个跨境贸易公司通过隐私支付完成海外供应商结算,可以避免暴露利润率和付款频率,同时确保税务合规。日常生活中,一位用户在数字钱包中匿名支付订阅费用或在线购物,也能享受类似的保护,防止消费习惯被广告商或社交平台捕捉和分析。

隐私支付不仅有助于保护个人信息,还能增强网络活跃度和信任感。人们更愿意在一个安全、可保护行为模式的网络中进行交易,这直接影响支付网络的采用率和经济活力。研究显示,数字支付用户在知晓网络支持隐私保护时,其使用意愿显著提高。这种信任不仅来源于技术保障,也来源于用户对数据控制权的认知。换句话说,隐私支付不仅是单笔交易的匿名化,而是一种长期、系统性的行为模式保护。

值得强调的是,隐私支付并不意味着无法监管或不符合法律合规。通过零知识证明、多方计算和同意披露机制,交易网络可以在不暴露敏感信息的前提下实现审计和合规要求。用户在享受隐私保护的同时,必要的信息仍可向监管或审计方授权披露,确保支付行为合法、透明且可控。这种设计不仅解决了隐私与合规的矛盾,也为区块链支付网络的广泛应用提供了基础。

BenFen正是这一理念的典型实践者:其隐私支付采用零知识证明与多方计算相结合的机制,实现交易金额、发送方与接收方地址的全面隐藏,同时支持监管方通过视图密钥(View Key)进行选择性审计,确保合规不牺牲用户隐私。

区块链隐私的演进——从匿名币到模块化基础设施

匿名币阶段:隐私理念的初步实践

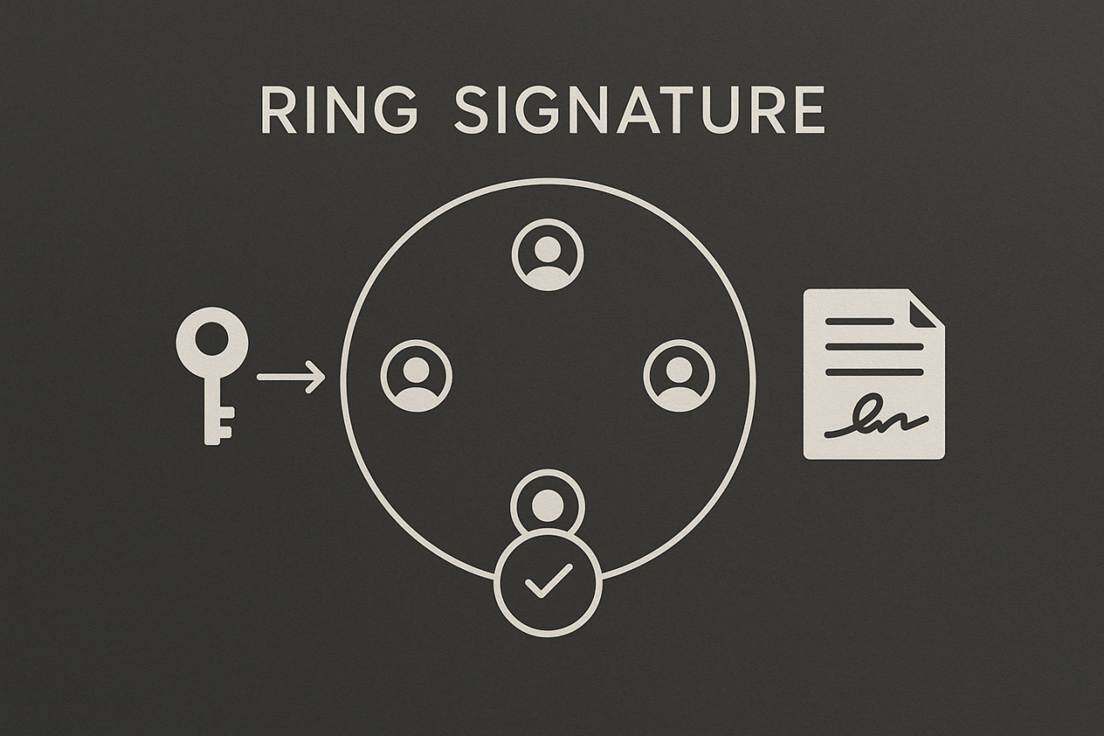

区块链隐私的最早尝试是匿名币,其核心目标在于保护交易双方的身份和交易金额。 Monero 于 2014 年发布, 是最早实现链上隐私交易的加密货币之一, 其核心机制包括 环签名(Ring Signature)和隐匿地址(Stealth Address)。每笔交易的发送者输入会与多个历史输入混合生成环签名 ,从而隐藏真实发送者,避免链上直接关联交易双方。 接收者则使用一次性隐匿地址接收资金 ,确保支付路径无法被外部观察者直接识别。尽管如此,如果将链上信息与链下数据结合(如交易所 KYC 信息、社交媒体或 NFT 交易记录),仍可能存在一定追踪风险。并且它的局限也十分明显: 交易数据体积较大,区块膨胀明显 (单笔交易大小显著高于比特币交易);同时,Monero 不支持复杂智能合约 ,限制了其在去中心化金融(DeFi)等应用场景的可用性。

Zcash 于 2016 年引入零知识证明(zk-SNARKs),允许用户在隐藏交易金额和参与方身份的同时,生成可验证交易合法性的数学证明。与 Monero 不同,Zcash 提供了“选择性透明”机制,即用户可以选择 shielded 交易以获得隐私保护。该技术在理论上能够保证交易有效性与隐私性,但生成证明需要较高计算资源,交易延迟明显,对普通用户体验造成挑战。早期采用率也相对较低,反映了隐私保护与使用便利性之间的权衡。

匿名币阶段奠定了区块链隐私的概念基础:它直接、明确地提出“通过隐藏信息保护用户安全”的理念,为后续协议层隐私和隐私计算阶段提供了技术与理念参考。同时,这一阶段也暴露了隐私保护与可扩展性、用户体验之间的矛盾,提示设计者必须在隐私、安全与可用性之间寻找平衡。

协议层隐私:满足智能合约需求

随着智能合约和去中心化金融(DeFi)的快速发展,早期匿名币在隐私保护上的局限逐渐显现。Monero 或 Zcash 等匿名币虽然能有效隐藏单笔交易的身份和金额,但在智能合约交互、复杂资产管理以及多笔交易聚合等场景中无法直接应用。为满足链上复杂应用的隐私需求,协议层隐私工具应运而生。

Tornado Cash 是基于以太坊的混币协议,通过混币池和零知识证明打乱交易路径,实现发送者与接收者的解耦,使资金流向难以被追踪,它为用户提供了链上隐私交易的实践案例。然而,Tornado Cash 也面临现实监管风险:2022 年美国财政部将其列入制裁名单,显示协议层隐私在合规性上存在挑战。此外,Tornado Cash 只是交易混币,不支持复杂智能合约的隐私操作。

Railgun 则为 DeFi 用户提供多资产隐私交易和智能合约交互能力,支持 ERC-20、ERC-721 等代币类型。用户在链上进行交易时可以隐藏身份、金额和交易关系,同时通过授权接口满足部分审计和合规需求。但 Railgun 的跨链支持有限,主要集中在 EVM 兼容生态,且使用门槛相对较高。

总体而言,协议层隐私阶段的核心意义在于:在链上应用中增强隐私保护,使智能合约和 DeFi 场景中的资金流向和用户行为不易被追踪。这一阶段的局限主要包括操作复杂、计算与 Gas 开销较大、跨链支持有限,以及现实监管风险。这些限制为后续隐私计算和模块化隐私基础设施的发展提供了明确方向,也凸显了区块链隐私技术从单笔交易保护向可验证、多功能隐私体系演进的必然性。

在本阶段的演进中,BenFen的隐私支付功能聚焦于实现高效的链上匿名交易,支持用户在隐藏身份和金额的同时,进行无缝的资金转移,旨在解决传统匿名币在移动支付和日常使用中的便利性问题,进一步扩展了匿名币在支付场景下的应用。

隐私计算阶段:可验证 + 隐私

协议层隐私更多关注交易数据的隐藏,而隐私计算的出现,让区块链从“信息掩盖”进入“计算可验证”阶段。它通过在加密状态下完成计算,确保数据既保持机密,又能验证结果的正确性,使得复杂智能合约、多方协作与跨链操作的隐私保护成为可能。当前主要的隐私计算技术包括零知识证明(ZK)、可信执行环境(TEE)与安全多方计算(MPC),它们分别代表了不同的技术路径与隐私支付实现方式,后文将对技术原理进行详细拆解。

可信执行环境(Trusted Execution Environment,TEE)

可信执行环境(Trusted Execution Environment,TEE) 依托硬件隔离机制,在CPU的安全区域内执行敏感计算,外部无法访问数据,从而实现硬件层隐私。代表项目包括 Oasis Network、Secret Network 与 Phala Network。

Oasis Network:以灵活架构为核心的隐私计算平台

发展时间线: 项目主网于2020年11月正式上线。其重要的里程碑是2022年推出的 Sapphire ParaTime ,这是一个兼容EVM的隐私区块链,极大降低了开发门槛。

核心特点与架构:

○ 共识与执行分离: 这是Oasis最核心的创新。网络分为共识层和多个并行的ParaTime执行层。共识层由验证者运行,负责安全与稳定;ParaTime层则由独立的节点运营者运行,负责处理智能合约等计算任务。这种设计使得多个ParaTime可以并行处理交易,极大地提升了可扩展性。

○ Sapphire ParaTime: 作为隐私赛道的关键产品,它允许开发者使用Solidity等标准工具,编写能够加密状态和私有交易的智能合约,实现了“开箱即用”的隐私功能。

应用与生态: 凭借其灵活架构,Oasis在 数据代币化(Data Tokenization) 领域布局深远,旨在构建负责任的数据经济。合作案例包括与 宝马(BMW Group) 合作开发数据空间,与 基因公司 Nebula Genomics 合作保护用户基因数据隐私等。

面临挑战: 其TEE实现依赖特定硬件(如 Intel SGX),存在因芯片漏洞导致的数据泄露风险;同时,其跨链生态与头部公链相比仍处于建设阶段。

Secret Network以“默认隐私”为特色的智能合约公链

发展时间线: 其前身 Enigma 于2017年启动,主网于2020年9月启动,是首个具有隐私保护智能合约的区块链。后来它的 Secret Ethereum Bridge 上线,增强了跨链能力。

核心特点: 作为 Cosmos 生态中首个主打“默认隐私” 的区块链,其“Secret Contracts”能确保合约状态和输入数据在加密状态下被处理,只有被授权的方才能查看。BenFen在 Move VM 上实现类似默认隐私,转账时隐藏金额与余额,并提供临时可见授权。

应用与生态: 天然适用于隐私DeFi、隐私NFT与隐私转账等场景,其生态应用在诞生之初就自带隐私保护属性。

面临挑战: 面临Intel SGX的硬件信任与漏洞风险。此外,其首要挑战在于需要吸引更多开发者,构建更繁荣的生态来证明“默认隐私”的广泛价值。

零知识证明(ZK)

零知识证明(Zero-Knowledge Proof,ZKP) 允许用户在不泄露原始信息的前提下,向外界证明某个陈述为真。它最早由学术界提出,但在区块链中被广泛用于隐私支付和可扩展性设计。典型代表包括 Aleo和Aztec等。

Aleo:链下计算与隐私智能合约

发展时间线: 项目于2019年启动,主网于2024年上线。Aleo是最早将ZK技术应用于隐私计算层的公链之一。

核心特点: 所有计算均在链下完成,链上只验证零知识证明,既保护数据隐私,又减少区块链负载。其专用编程语言 Leo 允许开发者轻松构建隐私支付、DeFi、身份验证等应用,降低开发门槛。

应用与生态: 主网上线后,社区出现了 私密支付钱包、匿名投票、私密 DeFi 原型应用

面临挑战: 生成零知识证明计算开销高,导致移动端和低算力设备难以运行,生态仍在初期阶段。

Aztec:以太坊生态下的隐私支付

发展时间线: Aztec 项目启动于2017年,2.0版本于2021年上线主网。

核心特点: 结合 zkSNARK 与 rollup 技术 ,将多笔私密交易打包生成统一证明,再提交至以太坊主网,实现隐私保护和 降低 gas 成本。

应用与生态:Aztec Connect 曾支持用户在以太坊上进行匿名支付和收益farming操作,但在2023年暂停运行。

面临挑战: 隐私与监管、性能之间的权衡仍然存在,同时开发者生态需要进一步完善。

总体来看, ZK 技术路线在隐私支付中具备高安全性与数学可验证性 ,尤其适合需要高隐私保护和可验证性的支付系统。其发展历程展示了 从学术原型到商业应用的逐步落地 ,并为后续 Layer 2 隐私支付与复杂智能合约提供了技术基础。而 BenFen 的隐私支付功能,则在此基础上进一步进化:通过深度融合 MPC 协议、零知识证明以及原生隐私币 AUSD,在链下协同生成隐私交易。系统会将输入金额、输出金额、发送方/接收方地址及资产类型等核心要素转换为加密承诺或隐私状态,并以 AUSD 作为隐匿资产的载体,确保交易中的资金流向无法被外界识别。链上只同步经过证明的最终有效状态变更,节点仅验证转换的正确性,而无法逆推出原始信息,从根源阻断链上数据分析,实现更强的资产与身份隐私保护。

安全多方计算(Multi-Party Computation,MPC)

安全多方计算(Multi-Party Computation,MPC) 允许多个参与方在不泄露各自输入数据的前提下,共同完成函数计算并获取结果。它是目前在隐私支付领域最接近商业化应用的技术之一。与ZK(通常需要可信设置)和TEE(依赖特定硬件)不同, MPC主要通过分布式算法实现隐私保障 ,通常不依赖复杂的前置信任假设。代表项目包括 Partisia Blockchain 与 Lit Protocol。

Partisia Blockchain:以MPC为特色的基础公链

发展时间线: Partisia是最早将MPC技术系统化应用于区块链底层架构的项目之一。

核心特点: 其目标是构建一个以MPC为核心功能的底层公链。通过结合 门限签名(MPC的具体应用)与秘密共享 等技术,将交易签名和复杂计算任务分布到不同节点执行,从而避免单点隐私泄露。算法上采用 混合MPC模型 ,并利用 同态加密 等方案优化效率。

应用与生态: 其MPC支付协议已在 去中心化广告结算 等场景中试点,支持在不公开敏感商业数据(如具体金额)的前提下完成验证与记账。这种设计使其成为 跨机构数据合作、企业级支付方案的理想选择。

面临挑战: MPC的主要瓶颈在于 计算与通信开销大 ,多方计算协议需要频繁的节点间交互,导致延迟较高、对网络条件要求严格。即使Partisia对算法效率进行了优化,但在要求低延迟的大规模公链环境中仍面临性能挑战。

总体来看, MPC路线代表了从机构信任向算法信任的深刻转变。 它不仅用于支付签名与结算,也逐渐拓展到 身份验证、数据共享与跨境支付领域。 为了突破性能瓶颈,业界也在探索 “混合隐私架构” ,如将MPC与ZK结合,利用ZK证明来压缩验证步骤,从而在保证隐私的同时加快最终确认过程。BenFen也正是通过 MPC+ZK 混合架构,成功突破性能瓶颈,成为,成为兼具隐私保护与高性能执行能力的新一代公链基础设施。

相较于ZK的“零知识证明”和TEE的“硬件黑箱”, MPC的核心优势在于“去中心化协作”。 它最适合需要 多方参与、复杂账户管理以及满足合规审计需求 的隐私支付系统。因此,MPC在隐私支付演进中扮演了 “连接传统金融与加密世界的桥梁” 角色,为后续技术方案提供了坚实基础。

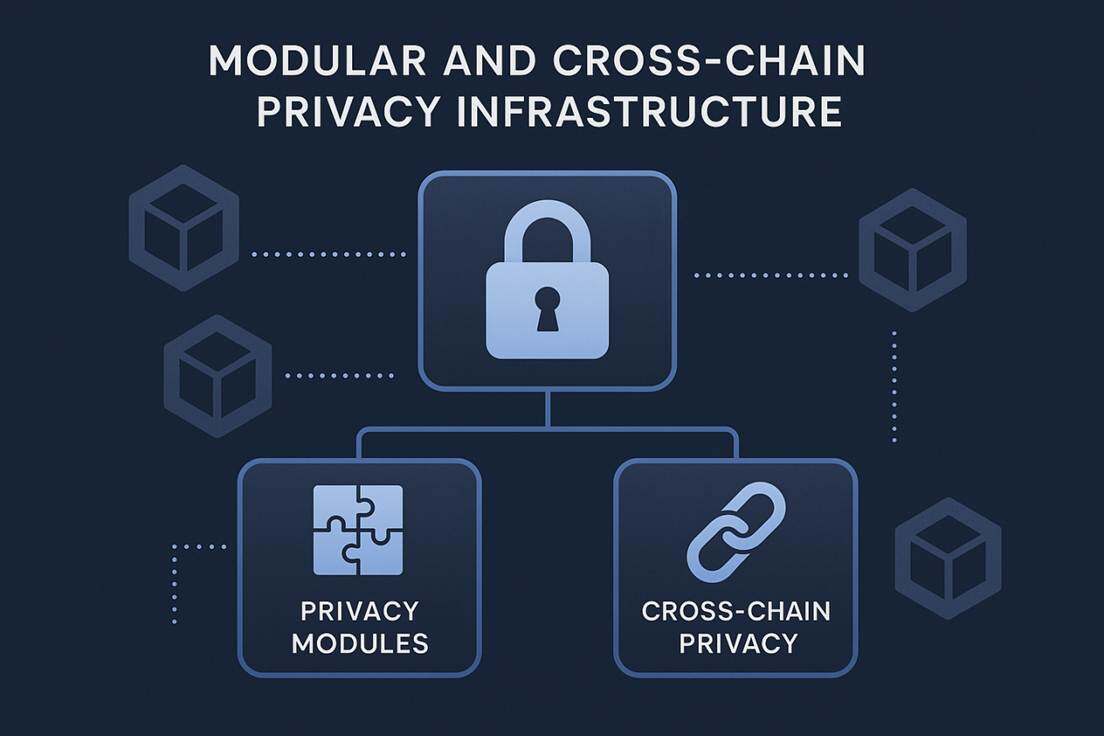

模块化与跨链隐私基础设施

随着区块链隐私技术的发展,出现了 模块化与跨链隐私基础设施 的趋势。模块化隐私基础设施通过将隐私功能从单链或单应用抽象为可复用组件,降低开发门槛,使开发者能便捷地构建隐私应用。例如, Aleo 提供可复用的隐私智能合约模块,实现私密交易和隐私智能合约功能。跨链隐私尝试实现不同区块链之间的隐私资产转移和部分合约交互, Oasis 的 Privacy Layer(Oasis Privacy Layer) 设计,让其它链 / dApp 能够接入隐私功能(通过桥接/消息层)来使用其隐私 ParaTime 的能力。但协议复杂,跨链安全性和标准化仍需完善。

这一趋势表明, 隐私正从单笔交易保护上升为基础设施级能力 ,能够支持 DeFi、隐私支付、数据交易和数字身份等多样化场景。但模块化与跨链隐私仍面临生态规模小、标准化不足、跨链安全性风险及互操作性限制。尽管技术潜力巨大,在大规模应用前仍需持续完善与验证。

技术路线对比:如何实现隐私支付?

零知识证明

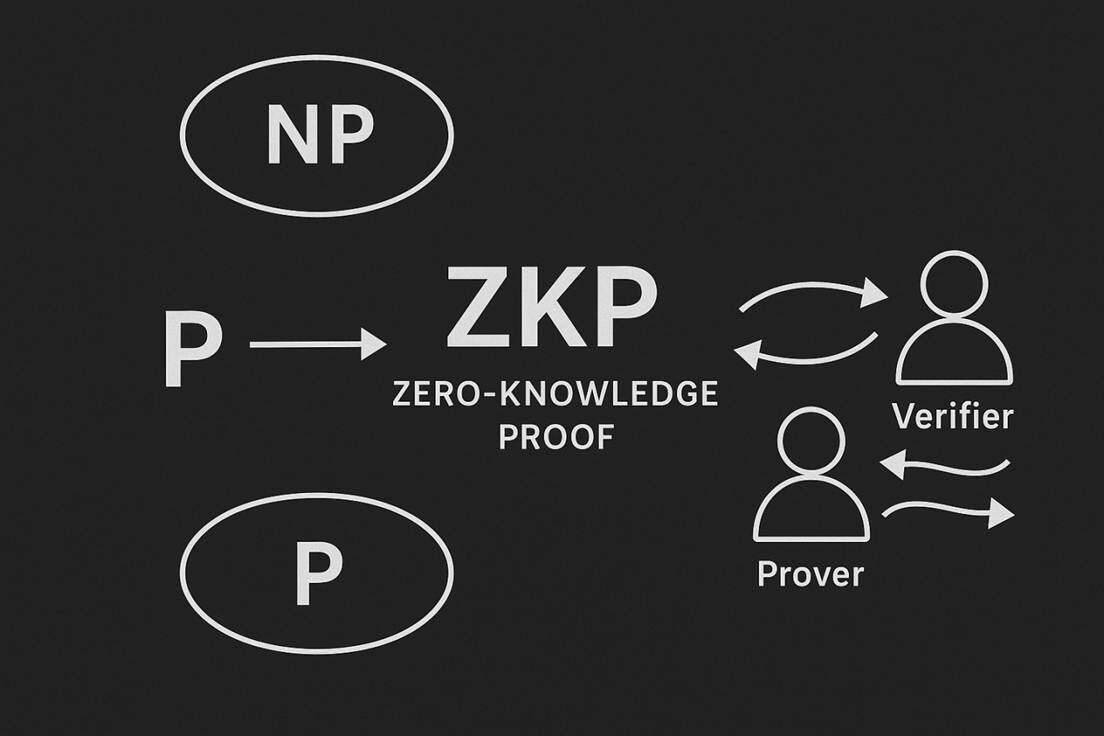

零知识证明与 NP 问题密切相关,故在进入这一模块之前,请容许我介绍一个数学难题: P 对 NP 问题。

作为七大千禧年难题之首,N对NP广为人知,但是因其问题表达的简洁性,大部分人并不了解 P=NP 意味什么。 P 指 Polynomial Time,可以简单理解为可以快速解决的问题。 NP 指 Nondeterministic Polynomial time ,可以简单理解为可以快速验证的问题。 所以 P 对 NP 问题实际的表述是对于一个可以快速验证的问题,是否有一种隐藏的方法快速解决,这两种能力是否是等价的? 若 P=NP,即如今看来难以解决的问题,比如物流调度领域的组合优化问题,是可以找到一个非常搞笑的算法进行解决的,但是相应的,对于基于大整数质因数分解、离散对数问题的加密领域会造成致命打击,因为黑客总会找到一个快速算法进行私钥的破解或密文的反推。 而如今的主流观点是 P与NP不等价,即我们不得不接受世界上的很多难题根本没有高效算法,我们不得不去不断近似,且永远无法找到最优解。

传统的 NP 验证思路十分简洁,只有两个步骤:

1. 提供证书:对于一个 NP 问题的实例,如果它的答案是“是”,那么必须存在一个简短的、能被高效检查的“证据”,这个证据就是证书。

2. 运行验证算法:存在一个确定性的算法。这个算法以问题实例本身和候选证书作为输入。如果该证书确实是问题的有效解,算法会在多项式时间内输出“是”;否则,输出“否”。

但这种验证思路有两个显著的缺点:证书信息隐私泄露与一次性被动接受证书。

为了解决这些问题,零知识证明应运而生。零知识证明概念最早在 1985 年 的论文 《The Knowledge Complexity of Interactive Proof Systems 》中被正式提出和定义,并于 1989 年在 Journal of the ACM 上发表最终版本。在这篇论文中,作者 Shafi Goldwasser,Silvio Micali 和 Charles Rackoff(GMR)引入了两个革命性的概念:交互式证明系统 和 知识复杂性。

传统的 NP 验证是静态的,一次性的,被动的,确定的。而交互式证明则是动态的,多次的,主动的,概率性的。在这个系统中,有一个证明者 Prover,P 与验证者 Verifier,V,V 通过多次向 P 随机发出挑战,来大概率确保 P 是正确的。逻辑是若 P 的命题正确,则任何有关该命题的问题 P 都可以回答,若 V 对 P 提出的所有问题都被准确回答,则 V 大概率认为 P 的命题正确。交互式证明系统须具有完备性与可靠性,即若陈述为真,诚实的 P 可以通过交互以极高的概率让 V 接受,若陈述为假,则任何 P 在交互后让 V 接受的概率微乎其微。

在传统的证明中,人们只关心证明是否有效,逻辑是否正确,但是 GMR 则提出了一个更深层次的问题:当一个验证者相信一个陈述为真时,他除了这个二进制结论外,还会额外学到什么知识?即证明过程本身会泄漏的信息量是多少。知识复杂性就是被提出来量化这种信息泄露的度量标准。值得注意,知识复杂性为零意味着验证者除了陈述的准确性外,没有得到任何其他信息,即零知识。

zk-SNARK 零知识简洁非交互式知识论证

GMR 提出的交互式证明系统革新了人们对于证明这一概念的认知,但是其本身有着臃肿的缺陷:交互式需要 P 与 V 时刻在线不停传输信息,且证明过程不具备重复性,无法进行有效的大范围广播。

针对这些缺陷,Blum、Feldman 和 Micali(BFM) 提出一种猜想: 能否用一种方式替代“交互”,让证明者可以独立生成一个完整的、任何人都能验证的证明?并给出了一个解决办法:需要引入一个一次性的、可信的预先设置阶段。这个设置阶段会生成一个公共参考字符串CRS。CRS 是一串随机的、公开的比特串。它在任何证明开始之前就已经生成。

BFM 的方案工作流程如下:

1. 设置阶段:一个可信方随机生成一个 CRS,并将其公开。这个步骤只需进行一次。

2. 证明生成:当证明者 P 想要证明某个陈述时,他不再需要等待验证者的挑战。 相反,他将 CRS 作为随机性的来源,来模拟验证者可能会提出的挑战。P 利用 CRS 和自己的秘密信息,独立地计算出一个单一的、非交互的证明。

3. 证明验证:任何验证者 V 收到证明 w 后,使用同一个 CRS 来验证 w 的有效性。因为 CRS 是公开的,所以任何持有 CRS 的人都可以担任验证者。

在对一个复杂计算进行传统验证时,需要消耗大量的时间与资源,这是边缘设备无法承受的。因此,人们眼中的理想验证状态是无论原始计算多么复杂,验证所需要的时间与资源都应该是很小的,是简洁的。1990 年代,概率可检查证明( PCP)被提出,核心思想是任何可以在多项式时间内验证的数学证明(即 NP 问题),都可以被转化为一种特殊的编码形式。验证者无需阅读整个证明,只需从这个编码后的证明中随机抽查极少数几个比特,就能以极高的概率判断整个证明的正确性。该定理无比强大,证明了存在一种方法,使得验证工作量与计算规模基本无关,而这正是人们对于验证的简洁性的追求目标。尽管 PCP 与 BFM 的提出是进步性的,但是由于当时时代的技术限制,以及仍没有相对成熟的密码学工具与之结合,故只是停留在理论层面,距离实际应用还很遥远。

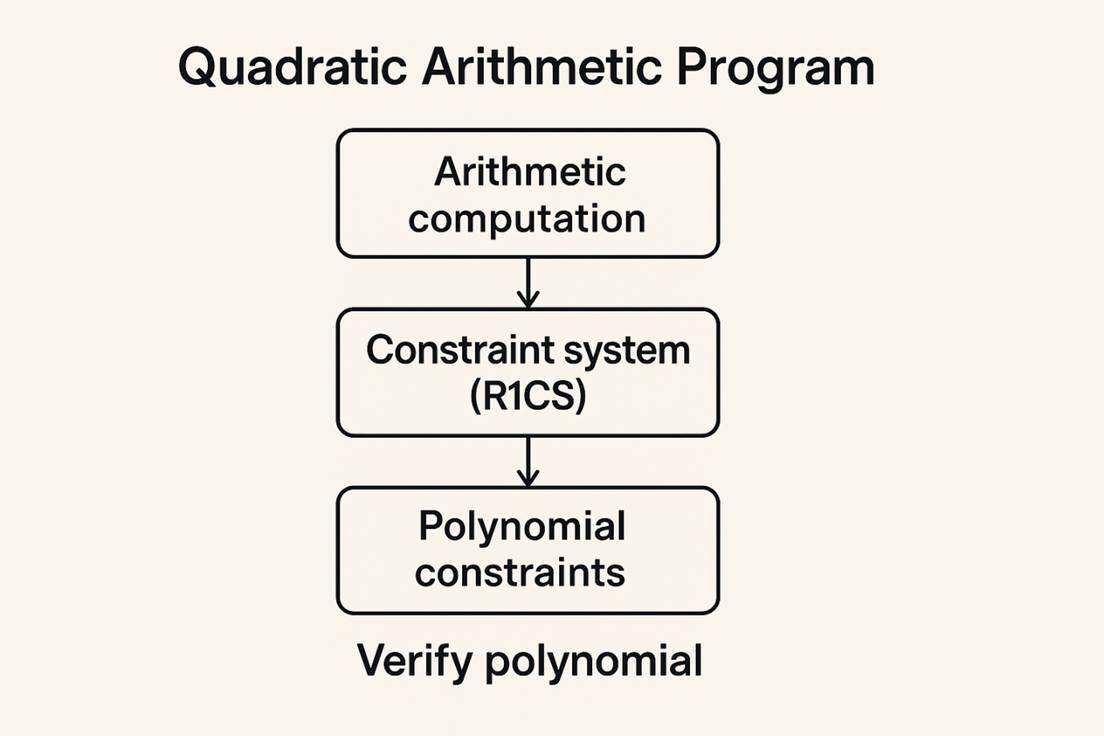

2012 年,第一个现实中真正实现的 zk-SNARK 被提出,即 Pinocchio 协议。这是一个划时代的突破。Pinocchio 协议提供了一个高效的编译器,可以将一段 C 代码转换成 zk-SNARK 所需的电路和参数。它首次证明了 zk-SNARK 可以用于验证现实世界的计算,虽然速度还很慢,但已经从一个理论概念变成了一个可工作的原型。同期,另一项独立工作 GGPR 也被提出,由由 Rosario Gennaro,Craig Gentry,Bryan Parno,Mariana Raykova 提出的 Quadratic Span Programs (QSP) 和 Quadratic Arithmetic Programs (QAP) 成为了大多数后续 zk-SNARK 系统的核心技术基础。

下面对这两项工作进行分别介绍

QSP 与 QAP 的目的都是将不同的计算问题转化为多项式问题,但作为 QSP 的改进版,QAP 更加简洁,更加规范,应用范围也更加广泛,故我们只会聚焦于 QAP。QAP 有一个较强的假设,即任何在确定性图灵机上可以在一定计算资源内解决的计算问题,都可以被转化为一个等价的、关于多项式整除性问题的算术电路。下面介绍 QAP 的核心流程:

1. 将任意计算分解为最为基本的加法与乘法操作

2. 构建约束系统(R1CS),为每一个逻辑门建立一组二次方程约束,即

3. 使用拉格朗日插值法,将 R1CS 转化为一个关于多项式的连续约束

4. 验证多项式的正确性

这样我们便将一个计算问题的证明转化为一个多项式问题,证明者只需要向验证者证明他知道最终构造的多项式即可完成证明。

在 QAP 的理论基础上,人们构建了 Pinocchio 协议,这是一个真正近乎实用的可验证计算系统。它优化了之前的理论构造,并实现了首个高性能的、通用的 zk-SNARK 原型系统,确立了现代 zk-SNARK 的基本范式。2016 年 10 月,加密货币 Zcash推出,通过使用 zk-SNARKs,Zcash 可以做到可以像比特币一样是公开的,也可以是屏蔽的,即隐藏发送方、接收方和交易金额。

zk-STARK 零知识可扩展透明知识论证

尽管 Zcash 取得了很大的成就,但是也暴露出 zk-SNARK 存在的一些问题:需要可信设置,可扩展性差,不抗量子计算等。因此,为了解决这一系列问题,2018 年,Eli Ben-Sasson 等人在论文《Scalable,Transparent,and Post-Quantum Secure Computational Integrity》中定义了一种全新的零知识证明构造 zk-STARK 零知识可扩展透明知识论证,其全称中的三个词正好对应了三大创新。

1. 透明 - 如何消除可信设置?

技术核心:使用公共随机源(哈希函数)代替可信设置

• zk-SNARK 的问题:其安全性依赖于在可信设置中生成的结构化公共参考字符串。这个字符串如果被参与者泄露,就可以用来伪造证明。

• zk-STARK 的解决方案:

○ 完全摒弃椭圆曲线配对和结构化参考字符串。

○ 使用抗碰撞哈希函数(如 SHA-256)作为唯一的密码学原语。

○ 系统的所有公共参数(特别是用于查询的“随机性”)都是在证明生成过程中,由验证者的挑战和哈希函数公开地、可重复地衍生出来的。不需要任何预先的秘密设置阶段。

2. 可扩展 - 如何实现对数级验证效率?

a. 将计算问题代数化(AIR)

首先,论文引入了一种称为代数中间表示的方法。它将需要证明的计算编码为一组多项式约束。这些约束描述了在计算的每一步,程序的状态必须满足的数学关系。

b. 使用 FRI 协议进行高效验证

这是实现“可扩展性” 的关键。FRI 协议用于证明一个函数确实是一个“低次多项式”。整个过程可以简化为一个多次交互的“挑战-响应”过程。

3. 知识论证 - 安全性如何保证?

• “知识论证”的含义:在密码学中,“论证”通常指 computationally sound 的证明,即安全性依赖于计算困难性假设。与之相对的是 information-theoretically sound 的“证明”,后者是无条件安全的。

• zk-STARK 的安全模型:

○ 它的安全性是基于哈希函数抗碰撞这一计算困难性假设的。

○ 它是一个“知识”论证,意味着如果证明者确实知道满足条件的“证据”,那么验证者会接受证明;如果证明者不知道,他成功伪造证明的概率极低。

同年,Eli Ben-Sasson 等人创建公司 StarkWare,将 zk-STARK 技术商业化,研发新的编程语言 Cairo,并发展了两个核心产品 StarkEx 以及 StarkNet,并发行 STRK 代币。在 2022 年 7 月完成 D 轮融资后,StarkWare 的估值达到了 80 亿美元。

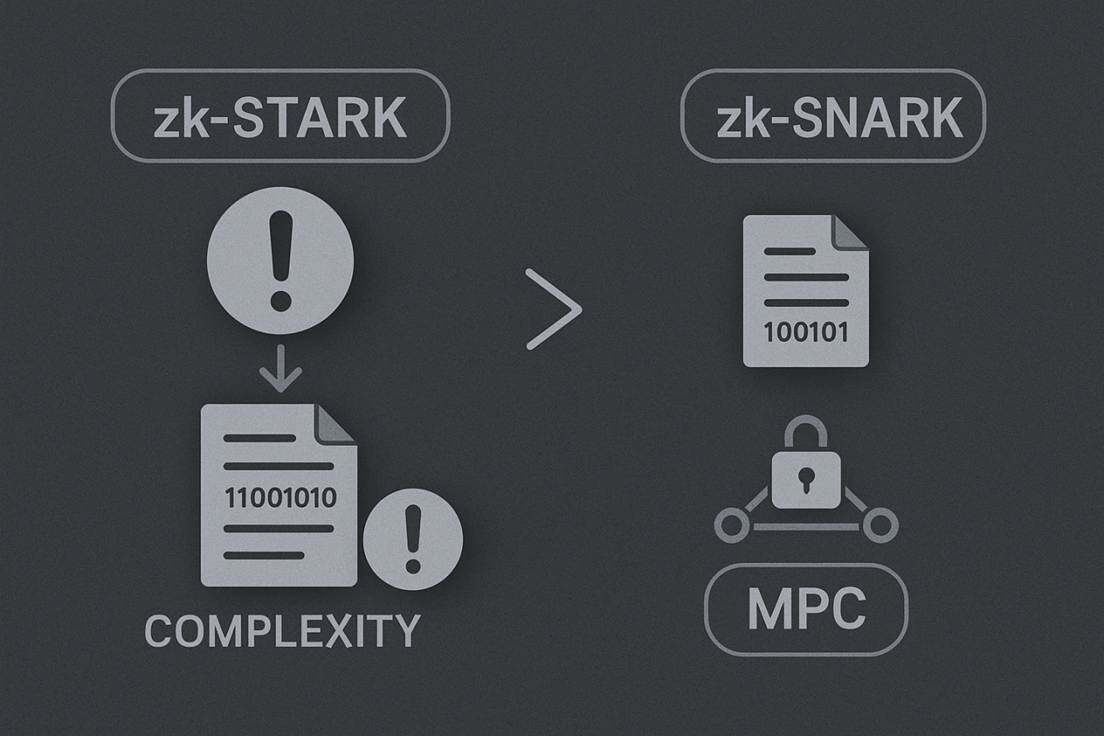

当然,zk-STARK 也有自身的问题,为了实现“透明性”(无需可信设置),zk-STARK 依赖于哈希函数和默克尔树等密码学原件,其交互式证明过程产生的数据量更大,生成的证明文件大小通常在几百 KB 级别,相比 zk-SNARKs 的证明(通常只有几百字节)要大得多。这严重影响了在链上的交易成本以及传输开销。此外,由于证明生成过程涉及复杂的数学运算, 计算复杂度很高,故生成一个 zk-STARK 证明需要大量的计算资源,这变相提高了用户的使用门槛。

此外,我们需要注意的是, 无论是Zcash还是StarkNet,它们都是基于零知识证明技术,但是零知识证明只能保证交易的隐私性,在私钥的管理,资产的配置,发生意外后进行恢复等问题上其实并没有一个良好的解决方案。ZKP本身的缺陷意味着我们必须使用其他技术与ZKP进行结合,来弥补自身的不足。幸运的是,MPC恰好可以给出一个近乎完美的解决方案,并且在与ZKP的结合过程中并不需要付出很大的代价。因此,与MPC进行结合是ZKP必须要走的道路,我们也会在后文进一步的介绍MPC的相关知识,并给出结合的具体方案。

混币器 & 环签名(Mixers,Ring Signatures)

一言以蔽之,混币器将资产匿名,混淆钱的来源,环签名将交易发送方匿名,混淆真实的签名者,但是二者的实现方式截然不同。

混币器

a. 存款(承诺)

• 用户生成一个秘密 s,并计算其哈希值 commitment = Hash(s)。

• 将资金与 commitment 一同存入合约。合约公开记录 commitment。

b. 等待(混合)

• 用户等待其他用户存款,以将自己的交易混入一个大的“匿名集”中。

c. 提款(证明)

• 用户想将资金提到一个新地址。

• 她生成一个 零知识证明 ,向合约证明:“我知道列表中某个 commitment 对应的秘密 s,且未重复花费”。

• 同时,她公开 nullifier = Hash(s)(与存款凭证相同)以防止双花。

d. 验证与发放

• 合约验证零知识证明的有效性,并检查 nullifier 是否未被使用。

• 验证通过后,合约将资金发送到用户指定的新地址,并标记该 nullifier 为已使用。

环签名

为了解决匿名泄漏的问题,2001 年,Ronald Rivest,Adi Shamir 和 Yael Tauman 共同提出环签名的概念。并在随后的几年时间中迅速发展,衍生出多种变体来应用于不同环境,如可链接环签名,阈值环签名,以及可追溯环签名等。可链接环签名可以防止同一私钥在环内重复签名,主要用于防止数字货币双花,如门罗币,可追溯环签名可在特定条件下揭晓签名者,主要用于需要问责的匿名系统,阈值环签名则需要多人合作才能生成签名,主要用于匿名协同授权等场景。基础的环签名依据实现方式,可以基本分为 RSA 与椭圆曲线两类。

下面介绍一个典型的基于椭圆曲线的环签名方案(SAG 范式)。

1. 密钥镜像

真实签名者(索引为 ( s ))使用其私钥 ( x_s ) 计算密钥镜像 ( I ):

其中 ( H_p(\cdot) ) 是一个哈希函数,将输入映射到椭圆曲线上的一个点。

2. 初始化与挑战链起始

签名者选择一个随机数 ( \alpha ) 作为种子,并计算初始承诺:

其中 ( H ) 是输出为标量的哈希函数,( G ) 是椭圆曲线的生成元。

3. 为其他成员生成响应(模拟)

对于所有 ( i \neq s ) 的位置(即非真实签名者),签名者随机生成 ( r_i ),并计算:

4. 为真实签名者生成响应(闭合环)

在真实签名者自己的位置 ( s ),他利用私钥 ( x_s ) 计算响应 ( r_s ),使得环闭合:

其中 ( l ) 是椭圆曲线群的阶。

5. 验证过程

验证者使用签名中的 ( c_1 ) 和 ( r_i ) 序列,对所有 ( i = 1 ) 到 ( n ) 重新计算:

最终,验证环是否闭合,即检查下式是否成立:

如果等式成立,并且密钥镜像 ( I ) 未被使用过,则签名有效。

具体实现

混币器最为出名的代表是 Tornado Cash,环签名最为出名的代表是门罗币,二者都具有强大的匿名性,但是也正因如此,一些国家的监管机构要求加密货币交易所下架门罗币,因为它难以符合反洗钱法规的要求。而在 2022 年,美国财政部外国资产控制办公室将 Tornado Cash 智能合约地址列入制裁名单,理由是它被用于清洗数亿美元的黑客赃款,其后 GitHub 代码库被封,开发者被捕。因此混币器与环签名虽然强大,但是因其难以追踪的性质,面临着强大的监管压力与法律风险。

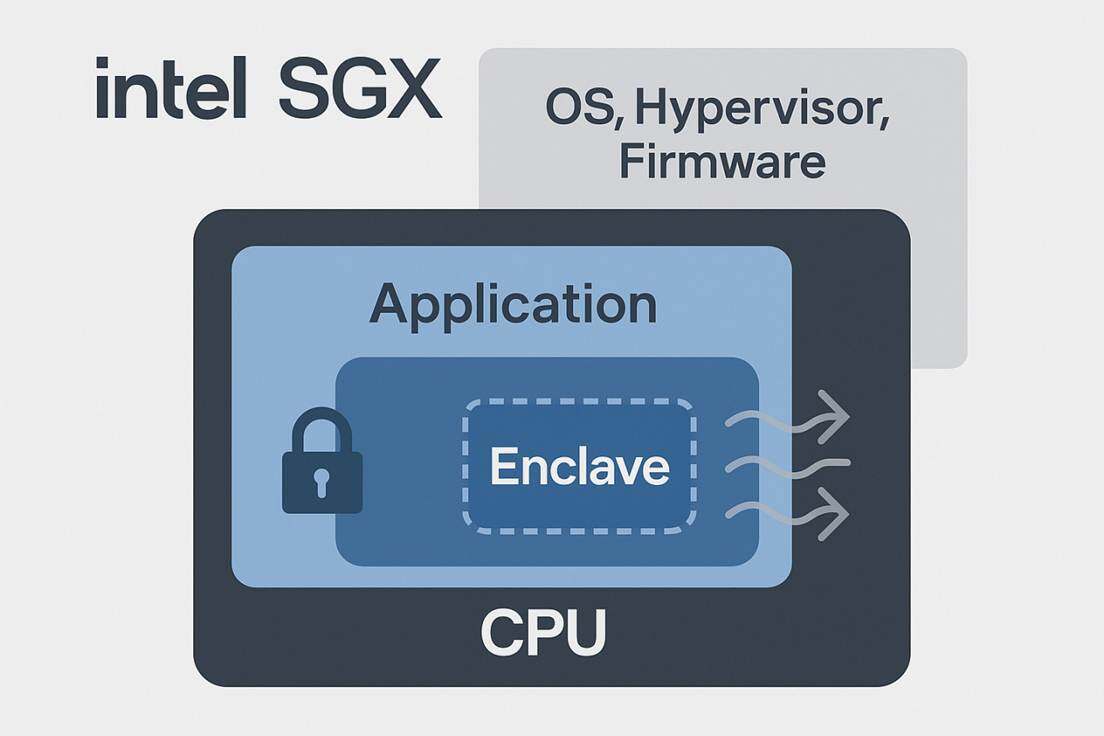

可信执行环境(TEE,Intel SGX)

可信执行环境(Trusted Execution Environment,TEE)是为保护计算设备中安全敏感程序的运行安全而提出的一项核心技术。其基本原理在于通过对硬件和软件进行严格的隔离,为敏感程序提供一个与通用计算环境完全隔离的安全运行环境。TEE 技术的诞生旨在解决传统计算模型中,操作系统或虚拟机监视器作为最高权限实体,可能成为潜在攻击面的根本性安全问题。BenFen链在隐私支付中借鉴TEE硬件隔离思路,通过链下MPC协同生成加密交易,仅将状态变更上链,同样实现了敏感数据的隔离保护,避免链上直接暴露。

TEE 的核心目标在于实现数据机密性、完整性以及计算过程的可信性。通过利用处理器内置的硬件安全特性,TEE 能够在执行代码时确保数据在内存中处于加密状态,并且只有在 TEE 内部才能被解密和处理。这种硬件辅助的隔离机制是 TEE 区别于纯软件沙箱环境的根本特征,提供了更坚固的信任根。

TEE 的核心价值在于建立了硬件辅助的信任边界。传统的软件隔离机制依赖于操作系统的正确性。一旦操作系统内核被攻破,所有运行在其上的应用数据和代码都将暴露。然而,TEE 通过在 CPU 内部划分出一个“安全世界”和一个“非安全世界”,使得安全敏感程序能够在 Secure World 中运行,即使 Normal World 中的 OS 或 Hypervisor 被完全攻陷,也无法直接访问或篡改 Secure World 中的数据和执行过程。

这种隔离机制的实现通常涉及特殊的内存管理单元、内存加密引擎以及特定的 CPU 指令集。例如,Intel SGX 通过加密页缓存来确保 Enclave 内部的数据在离开 CPU 边界后总是被加密的。这种设计通过将信任边界缩小到 Enclave 本身,大幅降低了系统的整体攻击面。下面进行主流TEE架构的解析:

ARM TrustZone (TZ) 架构分析

ARM TrustZone 是移动和嵌入式设备中最广泛部署的 TEE 技术。它基于硬件分区原理,将 SoC的硬件和软件资源划分为两个独立的执行环境:安全世界和普通世界。

核心原理:硬件级的隔离由 CPU 的特定模式位控制。在系统启动时,首先进入 Secure World,由安全操作系统负责管理 TEE 环境。两个世界之间的切换由安全监控器通过特定的 SMC指令进行管理。

隔离机制与挑战:TrustZone 的隔离粒度是操作系统级别的。这意味着安全敏感应用运行在一个完整的安全操作系统内核之上。虽然这提供了丰富的功能,但其安全模型依赖于安全操作系统本身的完整性和漏洞免疫性。安全操作系统的代码量远大于 Intel SGX 的微型 Enclave,因此其攻击面相对较大,需要持续的审计和维护。

Intel Software Guard Extensions (SGX) 架构分析

Intel SGX 是为数据中心和桌面平台设计的一种精细粒度的 TEE 技术。它将保护粒度缩小到了应用程序级别,允许开发者将应用中的敏感代码和数据封装在一个受保护的内存区域内,称为 Enclave。

核心原理:SGX 通过特殊的指令集和内存加密机制(EPC)实现隔离。EPC 中的数据在离开 CPU 芯片之前会被内存加密引擎加密,防止 OS、Hypervisor 甚至主板固件的窥探。

隔离机制与挑战:SGX 最大的优势在于其极小的信任根。Enclave 内部的代码是唯一受信任的软件。然而,这种深度集成到复杂的微体系结构中,导致 SGX 成为侧信道攻击的主要目标。例如,SGX 使用缓存和分页机制,这些共享资源成为攻击者利用计时差异进行信息窃取的完美信道。其远程证明机制也相对复杂,需要依赖 Intel 的签名服务来验证 Enclave 的真实性和完整性。

尽管 TEE 通过硬件隔离提供了强大的安全保障,但其信任模型并非完美无瑕。早期的 TEE 架构设计侧重于提供内存和执行逻辑的隔离机制,以抵抗来自高权限软件环境的直接窥探和篡改。然而,随着处理器技术的发展和微体系结构的日益复杂,研究发现 TEE 架构“仅提供隔离机制”的特性,使其无法有效抵抗利用微体系结构状态泄露的“软件侧信道攻击”。现代 CPU 为了追求极致的性能,广泛采用共享资源。这些共享资源在安全世界和非安全世界之间形成了意料之外的通信通道。当敏感程序在 TEE 内执行时,其内存访问模式会导致共享硬件资源状态发生可测量的变化。攻击者运行在非安全世界,通过测量这些微体系结构状态的变化,就能推测出 TEE 内部正在处理的机密信息,例如加密密钥或敏感算法的执行路径。

历史上曾发生过多次重大 TEE 安全漏洞和攻击案例,下面选择其二进行简单介绍:

1. Foreshadow (L1TF) - 针对 Intel SGX

• 时间:2018 年披露

• 核心漏洞:Intel CPU 的推测执行机制中存在缺陷,特别是 L1 终端故障。

• 攻击原理:利用 CPU 的推测执行漏洞,诱使 CPU 在发生故障之前,将飞地内受保护的数据加载到所有程序共享的 L1 缓存中。 然后,攻击者通过缓存侧信道攻击可以探测到这些数据,从而窃取飞地的密钥、密码等任何秘密。

• 严重性:极高。 它可以打破 SGX 的核心安全承诺,从飞地内部提取任意数据。 甚至存在针对操作系统内核和虚拟机管理器的变种。

2. AEPIC Leap - 针对 Intel SGX

• 时间:2022 年披露

• 核心漏洞:一种极其罕见的架构漏洞。 CPU 的内存映射 I/O 在设计上存在缺陷,使得未映射的内存内容可能通过 CPU 的预取器被泄露。

• 攻击原理:攻击者可以构造特定的 MMIO 访问,导致 CPU 预取器将飞地的私有数据加载到缓存中,进而通过侧信道提取。 其特殊性在于,这是一种可架构性验证的漏洞,不需要依赖侧信道分析的时间测量,理论上有更高的可靠性和精度。

• 严重性:极高。 它表明即使在微架构层面完美无缺,架构设计上的疏忽也可能导致毁灭性的数据泄露。

因此,TEE 技术的最大挑战不在于实现逻辑隔离,而在于如何应对由于 CPU 性能优化所引入的物理/时序上的共享通道。这一挑战迫使安全研究从单纯的隔离防御,转向复杂的运行完整性证明和侧信道免疫设计。

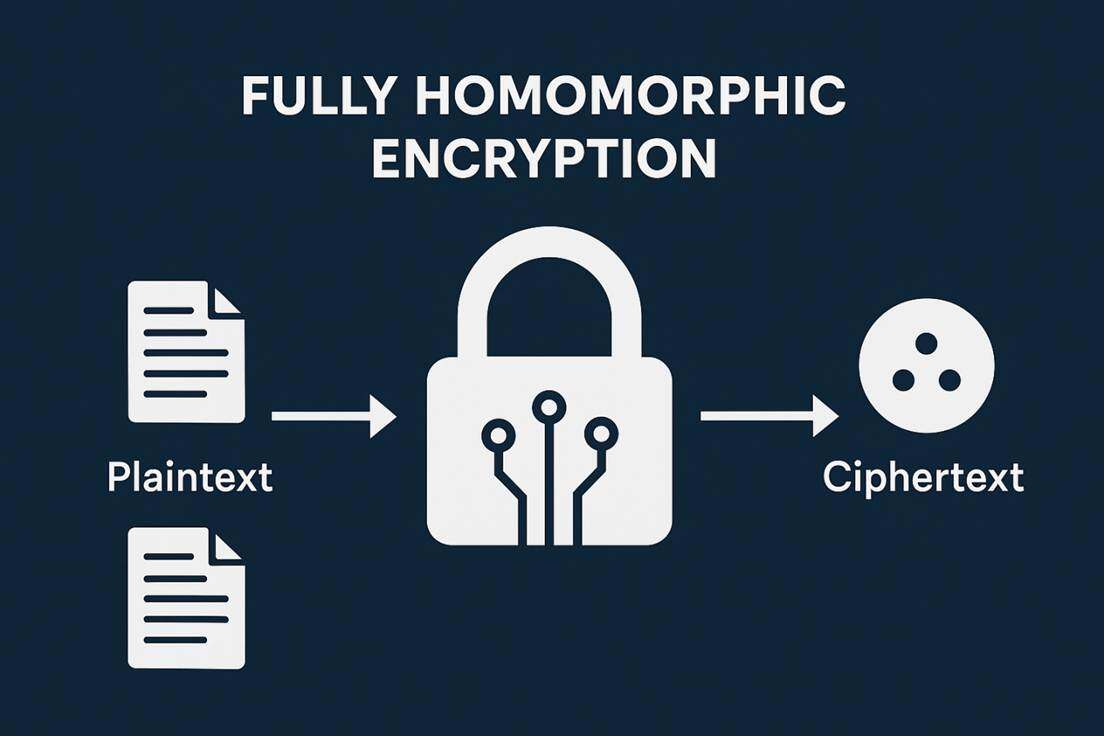

全同态加密 (FHE)

全同态加密(Fully Homomorphic Encryption,FHE)是解决隐私安全问题的有效方法。 它是一种强大的加密工具,核心能力在于允许对加密数据执行任意同态计算。这意味着,理论上可以对密文执行任何复杂的算法或构建任何计算电路,而无需事先解密。而BenFen链采用的FHE-MPC混合模型,在底层进行密态计算,确保数据不解密,这与FHE核心理念不谋而合。

全同态加密的发展史是一个从理论突破到工程实践不断优化的过程。它始于 2009 年 Gentry 提出的第一个可行方案,但该方案因计算效率极低而仅具有理论意义。随后,研究焦点迅速转向基于格困难问题的第二代和第三代方案,尤其是依赖于误差学习(LWE)和环误差学习(RLWE)的方案。

同态加密(HE)与全同态加密(FHE)的定义

一个加密方案 E 如果支持对特定运算 ∘ 的同态性,则称为同态加密(HE)。形式上,如果满足 E(m1)。E(m2)=E(m1∘m2),则称该方案具有同态性。

全同态加密(FHE)则是一种更强大的结构,它要求加密方案必须同时支持两种基本的同态运算。在布尔电路中,加法和乘法足以构建任何复杂的计算函数,从而实现对加密数据的任意同态计算。 这一能力使得 FHE 在计算上具备图灵完备性。

FHE 的前身:部分同态加密(PHE)

在 FHE 出现之前,密码学界已经发展出支持单一运算的加密方案,即部分同态加密(Partially Homomorphic Encryption,PHE)。

RSA 算法:RSA 是公钥密码学的基石之一。它具备乘法同态性。具体而言,对于密文 E(m1) 和 E(m2),其乘积在密文空间中解密后等于明文乘积的模 N 结果:E(m1)⋅E(m2)=E(m1⋅m2(modN))。然而,RSA 不能对密文进行加法运算。

Paillier 算法:Paillier 算法是另一种广泛使用的 PHE 方案,它具备加法同态性。密文空间中的乘法运算对应于明文空间中的加法运算:E(m1)⋅E(m2)=E(m1+m2(modN))。该方案在安全投票系统等场景中非常有效,但它无法对密文进行乘法运算。

关键障碍:从部分同态到全同态的跨越

部分同态加密(PHE)方案的局限性在于其无法支持通用计算。计算电路需要同时具备 AND 和 XOR 功能才能实现任意逻辑。RSA 和 Paillier 只能提供其中之一,故其应用范围受到严格限制。 更重要的是,由于 PHE 方案的运算次数往往是有限的或只支持单一操作,它们在设计上无需处理密文运算过程中产生的噪音积累问题。

从 PHE 到 FHE 的转变,不仅是增加了一个运算,更是跨越了图灵完备性的门槛。一旦要求支持任意深度的、混合的加法和乘法运算,加密方案为了保持安全性而引入的噪音就会成为致命的缺陷。这种对复杂度的需求,使得噪音管理机制成为 FHE 架构中不可或缺的核心组件。

2009 年,Craig Gentry 利用基于理想格上的困难问题,成功构造出了历史上第一个可行的全同态加密方案。这是一个里程碑式的理论突破,标志着 FHE 从理论幻想变为了实际可能。

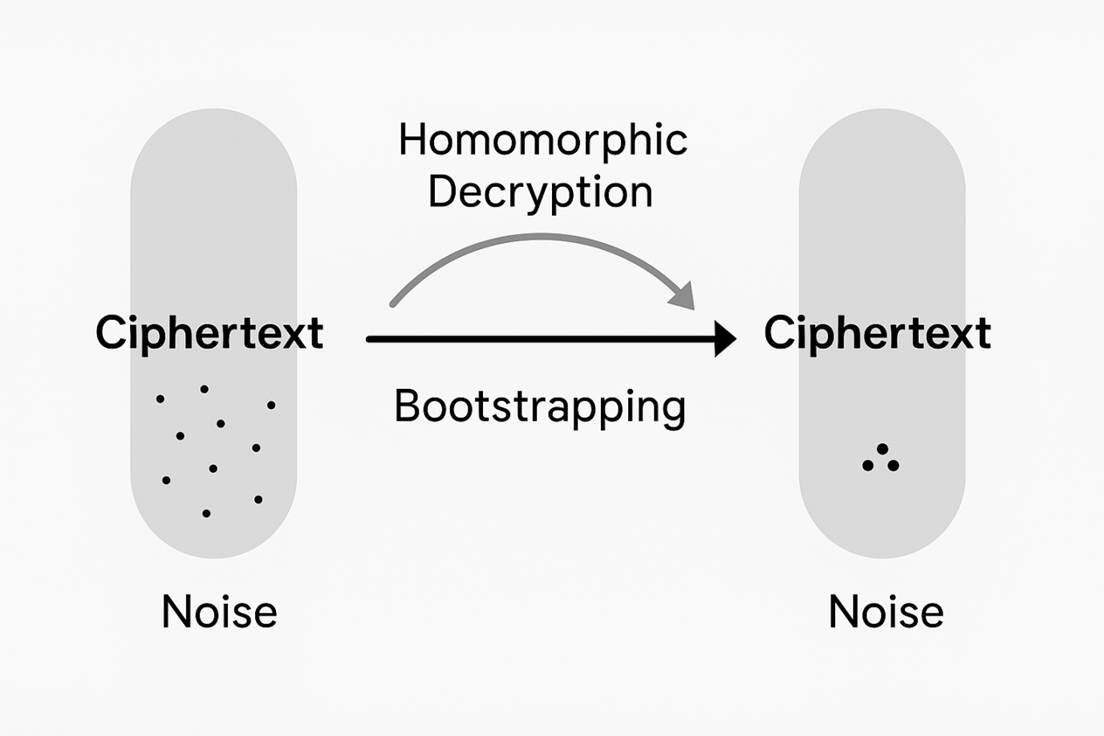

Gentry 不仅提供了具体的方案,还提出了构造 FHE 方案的普适理论框架。该框架的核心思想是将构建FHE分解为两个步骤:首先构造一个支持有限次同态计算的方案(SHE,Somewhat Homomorphic Encryption),然后通过 自举(bootstrapping) 机制,将 SHE 方案提升为可支持无限次同态运算的 FHE 方案。

在格基加密方案中,为了实现语义安全(即相同明文可以加密成不同的密文),加密过程中必须引入随机误差,即噪音。噪音的存在是 FHE 方案安全性的基础,但它同时也是 FHE 方案功能的最大障碍。随着同态运算,特别是同态乘法的不断进行,密文中的噪音会不断地累积和增长。一旦噪音的尺寸超过了方案参数设定的阈值,解密过程将无法正确恢复原始明文,从而导致解密错误。因此,必须设计一种操作来有效消减密文噪音,以确保计算的正确性。

自举是 Gentry 框架中解决噪音累积问题的核心技术。自举操作的定义是:当同态操作进行到密文噪音即将达到阈值而无法继续计算时,通过对该密文执行其自身同态解密的操作。在同态解密过程中,私钥本身需要被加密。自举的结果是生成一个新的、加密着相同明文的密文,但其噪音水平被大幅降低,从而允许继续进行后续的同态操作。因此,自举被认为是目前实现全同态加密的唯一途径,也是 FHE 方案中的关键和核心技术。

Gentry 方案作为第一代 FHE 的代表,其挑战在于如何让有限计算能力的 SHE 方案能够同态地评估自身的解密电路。Gentry 通过利用稀疏子集和假设,对解密电路中复杂的运算进行预处理,成功压缩了解密电路,使其能够在自身支持的同态计算深度内完成解密操作,实现自举。

然而,第一代 FHE 的实现代价极为昂贵。由于采用的是布尔电路对密钥信息进行逐比特加密,自举一个比特信息所需的时间约为 30 分钟。这一巨大的计算开销使得 Gentry 的方案在当时只是一个理论上的可行性证明,而非实用的技术。高昂的计算代价成为了 FHE 算法走向产业化应用的主要性能瓶颈。

向格困难问题 LWE 和 RLWE 的转变

为了克服第一代 Gentry 方案在基于理想格上实现的低效率和复杂的布尔电路结构,研究人员开始寻找更高效的代数结构和更易于管理的噪音模型。第二代 FHE 方案转向使用误差学习及其环变体环误差学习问题作为安全基础。

这一转变是 FHE 发展历程中的一个关键性工程决策。LWE/RLWE 提供的结构更利于噪音管理,尤其是 RLWE,它将复杂的矩阵运算转化为更快的多项式运算,为后续的优化奠定了基础。BGV(Brakerski-Gentry-Vaikuntanathan)和 BFV(Brakerski/Fan-Vercauteren)方案是这一代方案的典型代表。

BGV 和 BFV:分级同态加密与噪音管理

第二代方案引入了分级同态加密(Levelled Homomorphic Encryption,LHE)的概念。LHE 方案在参数设置时预先确定了方案能够支持的最大同态乘法次数(即电路深度)。

BGV 方案是基于 LWE/RLWE 的首批紧凑型 FHE 方案之一。它引入了动态的噪音管理技术——模切换。模切换机制不是完全依赖于成本极高的自举操作,而是在每次同态乘法之后,通过减小密文的模数来按比例降低噪音相对模数的大小。这有效地“买”得了更多的计算层级。 只有当所有的预设层级用尽,且需要进行更深层次的计算时,才需要执行完整的自举操作。

BFV 方案主要用于精确的整数算术。对 BFV 的优化着重于降低初始噪音和优化模切换过程。例如,通过预先计算 ⌊tq⌋m→⌊tqm⌋ 的方式来减少初始噪音。另一项重要优化是在重线性化操作之后执行模切换,从而减小模切换所需的维度。此外,对 BFV 模数进行分层处理,并在乘法后切换到更小的模数,可以减缓噪音增长速度。

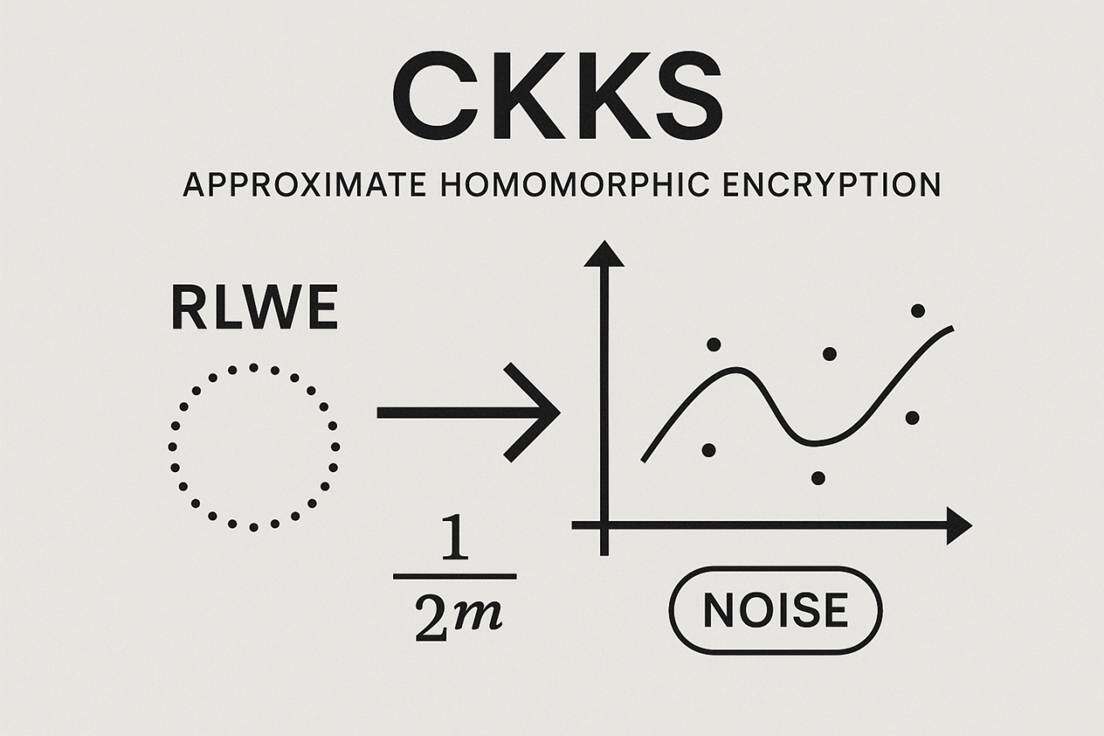

CKKS 类方案(Cheon-Kim-Kim-Song):近似同态加密

CKKS 方案是专门为处理实数或复数上的同态计算而设计的,支持近似计算,这对于统计分析、机器学习和 AI 应用至关重要。

核心假设:CKKS 方案建立在 RLWE 的代数结构上,因此它天然支持 SIMD 并行操作。

噪音处理与精度:CKKS 在设计上允许存在可控的误差,这些误差被用于编码浮点数的精度。因此,CKKS 的优化重点在于提升自举后的计算精度。研究人员通过使用不同的近似函数来精确地实现模约减操作。根据技术路线的不同,CKKS 类方案的自举精度范围广泛,从 24 位到目前最高的 255 位不等 。

FHE 为应对现代数据隐私挑战提供了独特的优势:

数据主权与隐私保护:FHE 的核心价值在于其能够在不信任的环境中对敏感数据执行计算,而无需向服务提供商暴露数据内容。这极大地增强了数据隐私的保护,并支持数据所有权和控制权的分离。

支持任意计算:FHE 通过支持加法和乘法两种基本运算,实现了对任意复杂函数的图灵完备计算能力。这使得 FHE 可以应用于复杂的机器学习模型评估、基因组学分析和金融建模等通用场景,而这是部分同态加密方案所无法企及的。

理论上的抗量子安全性:现代 FHE 方案(基于 LWE/RLWE)依赖于格上的困难问题。这些问题被密码学界普遍认为具有抗量子攻击的潜力,为 FHE 提供了超越传统 RSA 和 ECC 等经典公钥算法的长期安全优势。

高吞吐量(SIMD):采用 RLWE 结构的方案(如 BGV 和 CKKS)通过消息打包技术实现了 SIMD 操作。这使得 FHE 能够以批量方式处理数据,显著弥补了单次同态操作所带来的巨大性能开销,提高了实际应用中的数据处理吞吐量。

尽管 FHE 取得了显著进步,但其产业化应用仍面临多重挑战:

计算性能瓶颈:尽管自 Gentry 方案以来,自举时间已从 30 分钟缩短至毫秒级别,但与在明文上执行的计算相比,同态运算的计算成本仍然高得多。自举操作的计算代价依然昂贵,是当前 FHE 算法最主要的性能瓶颈。

密文扩展导致的存储开销:FHE 密文通常比原始明文数据大得多。这种密文扩展导致了巨大的存储需求和带宽消耗,增加了系统的复杂性和运维成本。例如,LWE/RLWE 密文为了抵抗噪音和支持重线性化,需要多个高维度的多项式来表示一个明文。

密钥管理的复杂性:FHE 需要管理复杂的密钥结构,特别是重线性化和自举所需的评估密钥,这些密钥尺寸庞大且管理难度高。

多方安全计算(MPC)

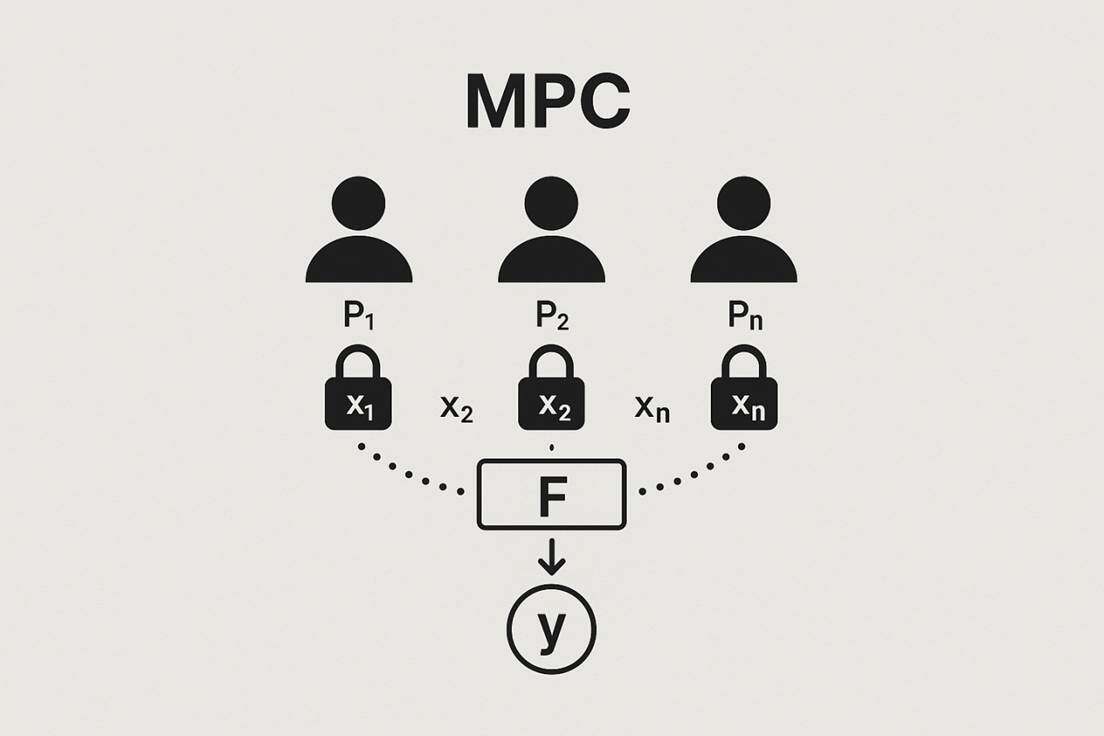

MPC 的核心范式与数学定义

多方安全计算(Secure Multi-Party Computation,MPC)是密码学领域的核心研究之一,其目标在于解决数据隐私和协同计算之间的根本冲突。MPC 允许 n 个互不信任的参与方 P1,…,Pn 在不泄露各自私有输入 x1,…,xn 的前提下,共同计算一个预定义函数 F(x1,…,xn)=y。这一范式通过将函数转换为易于加密处理的基本操作单元,从而在密文或共享数据上执行计算。

MPC 的安全性主要由两个核心属性定义:输入隐私性和结果正确性。输入隐私性要求任何参与方或外部攻击者都无法从协议的执行过程中学习到其他方输入的任何信息,除非是计算结果本身所蕴含的信息。结果正确性则保证协议的输出 y 必须准确地等于函数 F 在所有输入上的计算结果,并且防止腐败方影响输出的有效性。根据底层加密原语的不同,MPC 协议可大致分为两大类:基于混淆电路(Garbled Circuits,GC)的协议和基于秘密共享(Secret Sharing,SS)的协议。

报告的阶段性划分与历史里程碑概览

MPC 的发展并非线性的,而是经历了从抽象数学概念到实用化工程系统的跨越。本报告将 MPC 的演进分为几个关键阶段,旨在精确分析其理论基础的构建、安全标准的升级、工程效率的突破以及最终的产业落地:

1. 理论奠基与可行性证明:确立了 MPC 的两种基础协议范式。

2. 理论深化与模型拓展:引入系统级安全框架。

3. 效率突破与走出纯理论:通过代数优化和混合协议,将 MPC 从学术原型推向工程可行。

BenFen隐私支付系统体现了这些阶段的产业落地,其 FAST MPC 模块在初始版本中全部使用 MPC 实现保密交易生成与验证,后续迭代计划融合 FHE 等协议,提供更复杂的功能,如改进型 MPC 与高级密码学融合架构,支持秒级隐私确认和零 Gas 费体验。

理论奠基与可行性证明

1980 年代标志着 MPC 理论的开端,其核心贡献在于证明了通用安全计算的可行性,并确立了两种根本性的协议结构。

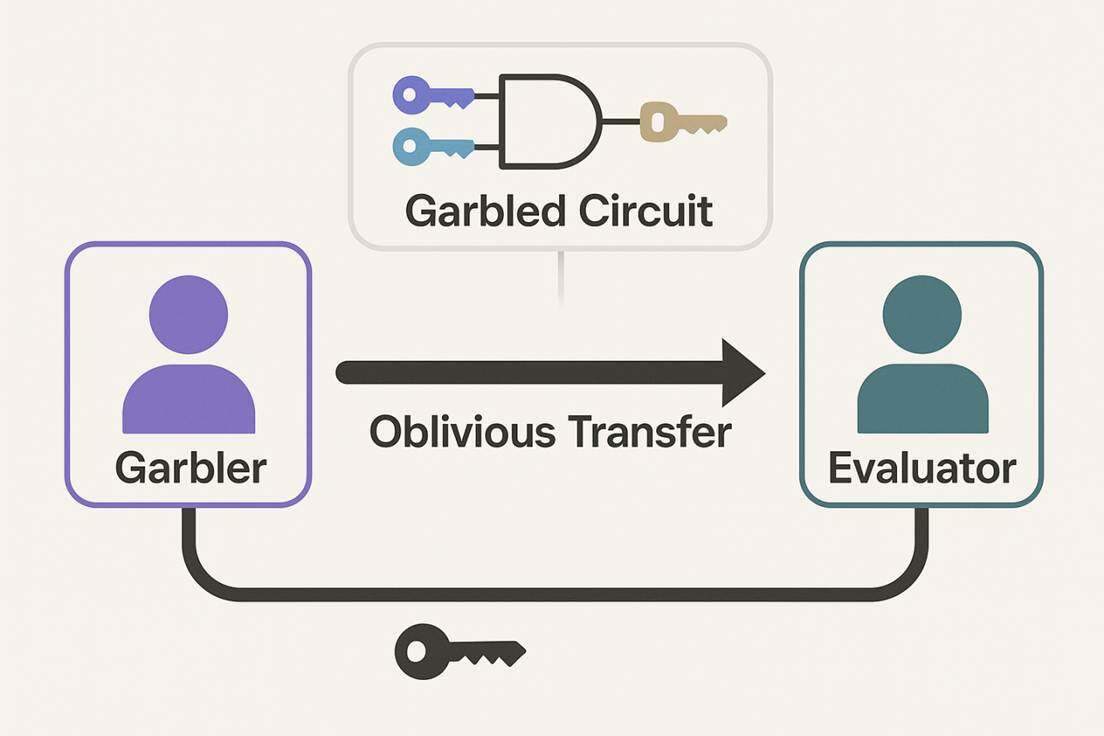

姚氏混淆电路(Yao’s Garbled Circuits,GC)

姚氏混淆电路协议是安全计算领域最具标志性的技术。虽然这一技术最初的构思可以追溯到姚期智在 1982 年提出的“百万富翁问题”(Millionaires' Problem),但 GC 的完整协议及其应用细节主要在随后的研究中被阐述。GC 协议的核心在于双边计算,它允许两个互不信任的参与方在无第三方的情况下,安全地评估一个函数。

GC 的机制要求将待计算的任意函数转换为一个布尔电路。协议中有两个主要角色:“混淆者”(Garbler)和“求值者”(Evaluator)。混淆者生成混淆电路,它包含用加密密钥替代真值表的加密门。 求值者接收混淆电路,并通过不经意传输(Oblivious Transfer,OT)机制安全地获取其输入的密钥标签,然后根据这些密钥对电路进行求值。GC 协议的显著优势在于其常数轮通信特性。无论布尔电路的深度或规模如何,通信轮数都是固定的。这一点对于广域网部署中的低延迟应用至关重要,因为它可以有效地避免与网络延迟相关的昂贵开销。然而,原始的 GC 协议天然适用于双边计算,将其推广到多方场景需要引入额外且复杂的机制。

GMW 协议与 BGW 协议

与基于 GC 的计算安全路径不同,1987年 Goldreich、Micali 和 Wigderson提出的协议GMW为通用多方计算提供了一条基于秘密共享和信息论安全的路径。

GMW 协议工作于布尔电路之上,其主要机制依赖于将输入秘密分享给所有参与方。在 GMW 协议下,如果腐败方的数量 t 满足诚实多数条件,则协议可以实现无条件的安全,即信息论安全,无需依赖任何计算复杂性假设。这意味着,即使攻击者拥有无限的计算能力,也无法从共享信息中学习到秘密输入。

与之并列的是 BGW 协议(Ben-Or-Goldwasser-Wigderson),该协议同样基于秘密共享,但主要应用于算术电路而非布尔电路。与 GC 不同,GMW 和 BGW 协议的通信轮数通常取决于待计算函数的电路深度。这种特性使得它们在网络延迟较大的环境中,性能表现往往不如常数轮的 GC 协议。

MPC 的理论奠基阶段确立了两种相互独立的安全性范式。GC 协议提供了常数轮、计算安全的解决方案,重点在于优化低延迟;而 GMW/BGW 协议则提供了信息论安全、依赖电路深度的解决方案,重点在于多方鲁棒性。这种分叉在理论上是必要的,因为它揭示了在不牺牲计算假设的前提下,要实现常数轮和多方信息论安全之间的内在矛盾。

尽管秘密共享本身不是一个完整的 MPC 协议,但它是 GMW/BGW 等多方协议的基础工具箱,用于安全地评估函数、抵御恶意行为。然而,在这一阶段,MPC 面临的主要挑战是缺乏一个能够同时实现高效率、多方支持、信息论安全和常数轮通信的通用协议。MPC 的初始实现面临着巨大的通信开销和复杂性,限制了其在实际场景中的应用。

理论深化与模型拓展

在 MPC 的可行性得到证明后,研究的焦点转向了如何定义和确保协议在复杂、动态和组合环境中的安全性。

通用可组合性(UC)框架

Ran Canetti 在 2001 年左右提出了通用可组合性(Universal Composability,UC)框架,旨在解决传统密码学模型中协议的安全性问题。传统安全定义往往只关注协议的“独立”(stand-alone)安全性,而忽略了当协议作为子程序与其他协议并行或嵌套使用时可能产生的漏洞。

UC 框架的核心思想是将协议的安全性定义为与一个“理想功能”的等效性。理想功能是理论上抽象的、完全安全的实体,它完美地执行所需的计算和安全保证。如果一个真实协议 P 在任何环境中都与这个理想功能 F 无法区分,则 P 是 UC 安全的。UC 框架在交互式图灵机模型中对协议进行建模,这些机器通过读写通信带激活彼此,模拟计算网络中的通信和计算。

UC 框架的引入极大地提高了密码学协议的设计标准,成为现代密码学协议安全分析的通用语言。然而,UC 也很快揭示了理论上的限制。UC 模型下的研究表明,在“纯模型”下,实现 UC 安全的多方计算是不可能的。这一不可能性结果迫使研究人员转向非纯模型,例如依赖于非延展承诺或其他形式的公共设置假设。这意味着,为了在复杂系统级环境中实现安全性,MPC 协议必须依赖于某些基础设施的预设,而不能是完全孤立的协议。此外,UC 框架对异步通信和网络延迟的明确建模,例如通过延迟机制揭示信息泄露,也间接推动了对常数轮协议的持续优化,以提高对网络环境变化的容忍度。

效率突破与走出纯理论

MPC 在 2000 年代中后期迎来了关键转折,一系列算法和工程上的改进使 MPC 从一个学术概念转变为一个工程可行的系统。

早期通用 MPC 系统的实现:Fairplay (2004)

Fairplay 是第一个值得注意的通用安全计算系统实现,由 Malkhi 等人于 2004 年推出。 Fairplay 的问世标志着 MPC 研究首次大规模地从理论论文进入到工程实践领域。

Fairplay 系统包括一个高级过程定义语言 SFDL,一个编译器将 SFDL 转换为 SHDL 以及执行姚氏协议的 Alice/Bob 程序。该系统的主要安全保障是其计算结果等同于一个指定的受信任第三方,即保证计算结果的正确性,并保证除了结果本身蕴含的信息外,输入数据不会泄露。

Fairplay 的实现至关重要,它不仅验证了理论的可行性,更重要的是,它暴露了实际应用中的巨大性能瓶颈,尤其是电路编译和通信开销。这种工程实践对理论研究产生了反哺作用,直接激励了对底层加密原语和电路结构的优化研究。

混淆电路的高级优化技术

GC 虽然具有常数轮优势,但其通信开销与电路规模成正比,成为早期实用化的主要障碍。

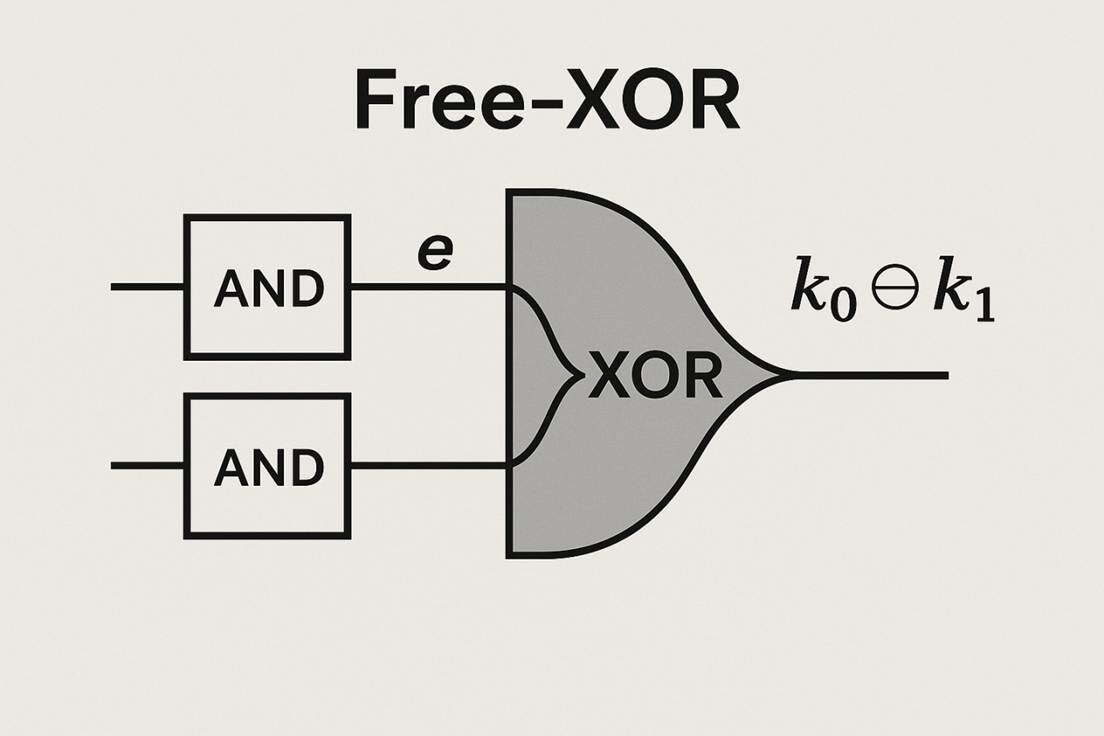

Free-XOR 技术

Kolesnikov 和 Schneider 引入的 Free-XOR 技术是 GC 效率史上最重要的里程碑之一。 该技术通过精巧的密钥标签结构设计,使得 XOR 门的评估可以完全免费,即不需要任何额外的加密操作或通信开销。该技术极大地降低了布尔电路的带宽和计算负担,特别适用于包含大量加法或异或操作的函数,如内存访问和部分哈希运算。Free-XOR 的优化效果显著,并随后被推广到多方协议,例如 BMR 协议。此外,通过引入半门等进一步的优化,每个 AND 门所需的加密操作被压缩到只需两个密文,实现了 GC 的进一步压缩和加速。

恶意模型下的 Cut-and-Choose 优化

在恶意安全模型下,Cut-and-Choose 技术虽然有效,但其本身也带来了巨大的成本。研究工作专注于优化 Cut-and-Choose 的参数选择。通过将 Cut-and-Choose 游戏形式化为约束优化问题,并考虑检查成本与评估成本的差异,研究人员能够设计出更优的策略,从而在恶意模型下将带宽效率提升一个数量级,总时间效率提升 12% 至 106%。

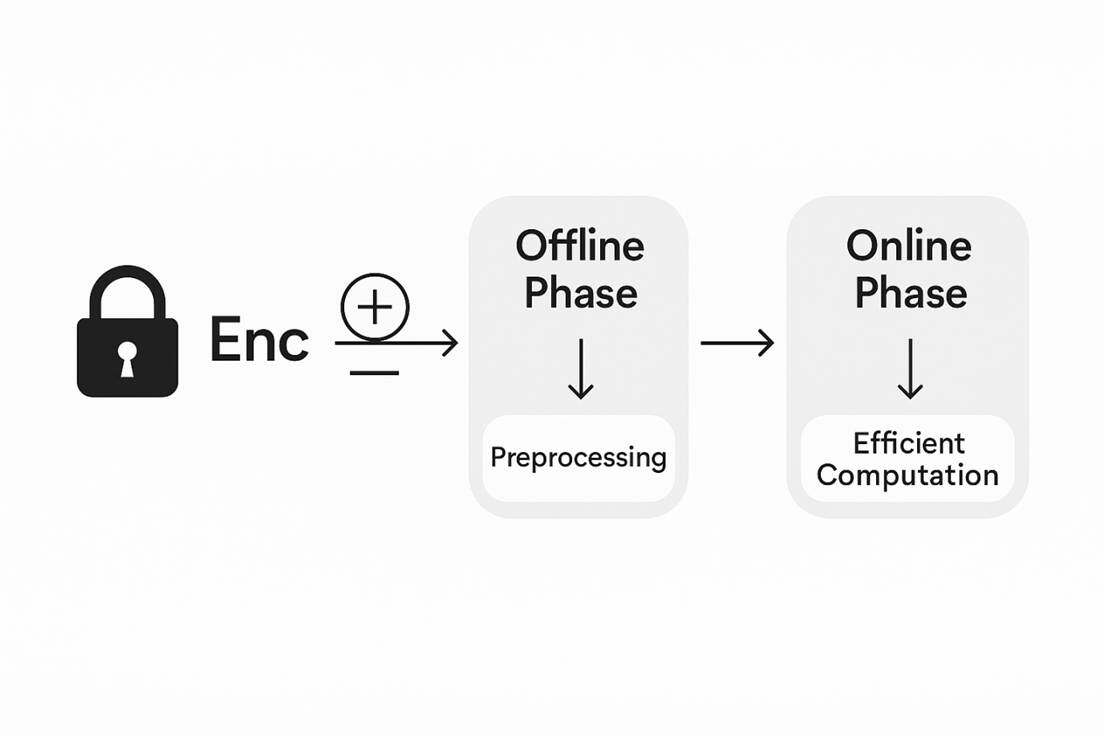

混合协议(Hybrid Protocols)的诞生与高效预处理

认识到纯 GC 和纯秘密共享协议各自的局限性后,研究人员开始设计混合协议,结合两者的优势。

集成半同态加密

混合协议的核心在于利用半同态加密或全同态加密(FHE)的特性。SHE 允许对密文进行线性运算(如同态加法)。这种集成使得协议可以采用预处理/在线阶段(Offline/Online Phase)的分离架构。

在预处理阶段,参与方利用 SHE 或相关的密码学原语,如 Oblivious Transfer (OT) 生成像 Beaver 三元组或 Oblivious Linear Evaluation (OLE) 关联随机性等所需的密码学材料。这个预处理阶段通常是计算密集但非交互式的,并且与实际输入无关。

在在线阶段,当私有输入到达时,协议仅涉及高效的共享交换和信息论 MACs 的验证,无需任何昂贵的密码运算。这种架构将计算负担和网络延迟敏感性转移到预处理阶段,使得对用户体验更重要的在线阶段(Online Phase)变得极其高效。

多方安全计算的发展历程是一部从纯数学可行性证明到高效率工程实现的演进史。始于 1980 年代的理论奠基,MPC 确立了基于 GC 的常数轮计算安全和基于 GMW/BGW 的电路深度轮信息论安全的两个主要分支。随后,UC 框架的引入提高了安全标准,揭示了在复杂环境中实现安全所需的基础设施要求。

2000年代中后期,工程实践(Fairplay)暴露的瓶颈直接驱动Free-XOR、Half-Gates 等代数优化,以及 SHE/OLE 驱动的混合协议架构。这些技术将 MPC 的效率提升了数个数量级,使其能够在商业部署中具备实用性,甚至在恶意安全模型下实现了接近非安全计算的效率。

我们选择 MPC 的原因

MPC 与隐私支付的结合

MPC 在去中心化密钥管理中的应用

多方托管与无助记词恢复

MPC 在密钥管理中应用的核心是阈值签名方案(Threshold Signature Scheme,TSS)。TSS 使得 N 个参与方在不重建私钥明文 S 的前提下,通过协作生成一个有效的数字签名,只要集齐 T 个份额即可完成签署。这使得私钥 S 永远不会以明文形式存在于任何单一设备或单一实体手中。

MPC 钱包利用这一特性,解决了传统加密货币存储的两个核心难题:助记词丢失和私钥泄露风险。通过将密钥份额分散存储并设置门限机制,MPC 提供了一种原生的多重授权框架。

BenFen在这一领域表现尤为突出,其基于 MPC 的阈值签名方案(TSS)通过将私钥分割为多个加密份额并分布存储于不同节点,确保了私钥永不以明文形式出现,无助记词恢复机制允许用户通过多方协作恢复资产,而无需依赖传统的助记词备份,显著降低了因助记词丢失或被盗导致的资产风险。此外,BenFen 的 TSS 架构支持动态参与方管理,允许在不影响安全性的前提下灵活调整签名门限,从而适应多样化的机构和个人用户需求。

机构级安全与合规

对于机构金融,MPC 提供了一个高鲁棒性的安全框架。任何大额交易的签署都需要通过预设的多数方共识,确保了资金的安全性。此外,MPC 的鲁棒性源于其 (t,n) 安全模型,即使在 t 个参与方离线或恶意行为的情况下,系统仍能正常运行或检测到欺诈,确保了高可用性。

隐私支付与清算

在金融领域,MPC 可以用于机构间或联盟链上的隐私清算。各方可以将加密的交易数据作为输入,共同计算清算结果、风险敞口或信用额度,而无需向其他合作方透露底层交易的详细数据。这使得机构能够在维护数据主权的同时,进行必要的金融协作。

反洗钱 (AML) 协同

MPC 在合规领域具有巨大的潜力。银行和监管机构可以利用 MPC 联合运行复杂的分析模型,例如识别跨机构的洗钱活动或欺诈模式。关键在于,这一过程可以在不共享客户个人交易记录或透露敏感数据的前提下完成。MPC 确保了只有分析结果才会被输出,而原始输入数据始终保密。

例如BenFen的 MPC 解决方案在反洗钱(AML)和合规分析中提供了切实可行的工具。其平台支持多家金融机构通过 MPC 协议联合运行复杂的 AML 模型,例如跨机构的交易模式分析,以检测潜在的洗钱或欺诈行为,而无需共享原始交易数据。

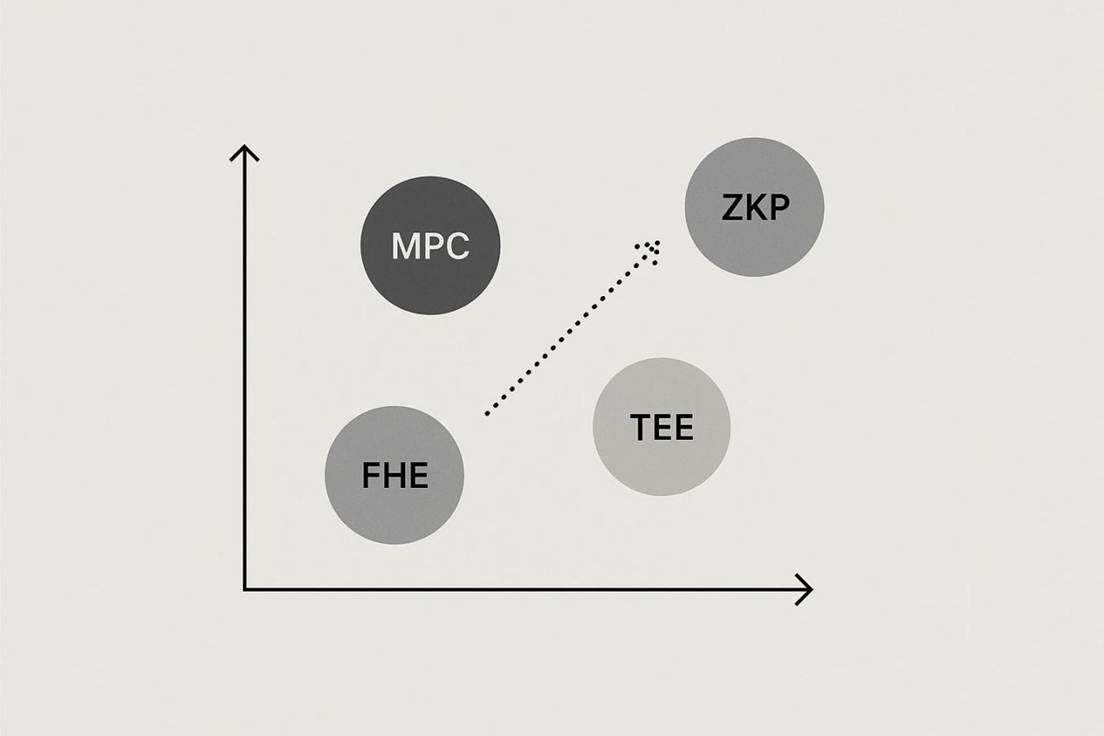

MPC 与其他技术路线的对比优势

理解 MPC 的战略定位,必须将其与其他主流隐私增强技术进行明确区分:

• MPC vs FHE:MPC 的设计目标是实现多个参与方对共享秘密信息的通用计算;FHE 的设计目标是允许单一数据所有者将加密数据外包给一个不受信任的服务器进行任意计算。

• MPC vs ZKP:MPC 是一种通用的计算工具,可以计算任何函数;ZKP 是一个验证工具,其输出结果是布尔值,仅用于证明某个语句的真实性而不揭示额外信息。

• TEE 的独特性:TEE 不依赖于密码学协议,而是依赖于处理器厂商提供的硬件隔离区域,在隔离区域内进行明文计算。

性能比较

性能指标对比:计算开销与通信成本

性能是决定 PETs 是否能在实时金融应用中落地的关键因素。下文详细对比了各技术在计算开销、延迟、通信成本和集成难度方面的差异。

计算开销与延迟

FHE 虽然具有理论上的最大灵活性,但其代价是极高的计算开销。FHE 的计算速度比明文计算慢 1 万到 10 万倍,这种高延迟和高开销使其难以在对实时性能和成本敏感的应用中推广。

相比之下,MPC 的计算开销则要低得多,实践中 MPC 通常比 FHE 更快。在延迟方面,TEE 接近于普通执行,延迟最低;MPC 的延迟属于中低范围,但极易受到网络通信状况的影响 ; 而 FHE 由于需要频繁进行自举操作,延迟最高。对于需要实时响应的隐私支付服务,FHE 的高延迟是一个难以克服的工程障碍,而 MPC 提供了切实可行的中低延迟解决方案。

通信开销与集成难度

MPC 的主要技术弱点在于通信开销。MPC 协议需要参与节点之间进行大量、频繁的交互式通信。当参与方数量(N)增加时,通信成本和同步问题会显著提高,成为效率瓶颈。相比之下,FHE 在客户端-服务器模型中所需传输的数据量相对较少。

在集成难度方面,TEE 项目具有最低的门槛,对现有编程模型的改动最少。而 MPC、ZKP 和 FHE 的集成难度都较高。其中,ZKP 和 FHE 通常需要专门的电路设计和编译过程;MPC 则需要复杂的协议栈集成和跨节点通信的架构设计。

可扩展性分析:MPC 与 ZKP 的自然横向扩展能力

可扩展性是决定基础设施能否支撑大规模应用的关键。MPC 和 ZKP 在架构上表现出明显的优势,因为它们“天然地支持横向扩展” 。MPC 可以通过分片技术来实现这一点,而 ZKP 则通过 Rollup 机制来实现。这意味着系统可以通过增加通用计算节点来线性地提高处理能力,这与云计算和分布式系统的现代趋势高度一致。

相反,FHE 和 TEE 的可扩展性则受到计算资源和专用硬件节点供给的限制。例如,TEE 的应用受限于硬件的内存容量和侧信道攻击风险,而 FHE 需要巨大的计算资源。依赖于软件和密码学的 MPC 和 ZKP,与去中心化系统对弹性、通用硬件和开放扩展模型的需求更为一致。因此,选择 MPC 是对未来大规模、去中心化基础设施的长期投资,避免了 TEE 带来的硬件依赖和潜在中心化风险。

鲁棒性与故障容忍:MPC 的 (t,n) 安全模型

MPC 协议在设计之初就内置了故障容忍能力。基于秘密共享的 (t,n) 门限机制,系统可以容忍最多 t 个参与方发生故障的情况下,仍能保证计算的正确性或至少保证恶意方的欺骗被及时发现。这种内生的鲁棒性使其特别适用于要求高可用性和资金安全性的金融服务。

结论与展望

MPC 在功能、性能和去中心化之间的最佳平衡点

选择 MPC 的核心理由在于它在实用性、安全性和去中心化之间找到了最佳的工程平衡点。FHE 虽然理论上提供了最强大的隐私保护,但其极高的计算延迟使其在绝大多数实时或近实时应用中不可行,特别是对于高频率的金融交易。MPC 提供了“足够好”的隐私保证和“足够快”的性能,能够有效地满足高吞吐量金融系统的实际需求。

在关键的信任模型方面,MPC 的分布式密码学信任模型在面向 Web3 和去中心化金融时,具有不可取代性。在涉及密钥管理和资产托管等对信任依赖要求最高的场景中,依赖单一硬件制造商的 TEE 架构在战略上存在中心化缺陷和抗审查风险,因此不可接受。MPC 是唯一符合去中心化、高安全标准和实用性能要求的解决方案。

MPC 与其他 PETs 的协同策略:构建混合安全架构

战略建议是采用混合安全架构,以 MPC 作为核心计算层,并与其他技术协同工作:

1. MPC 作为核心计算引擎:执行关键的、高频率的、需要多方参与的安全计算任务,如 TSS 签名、联合风控模型运行和隐私清算。

2. ZKP 作为验证和完整性层:在处理大规模数据或 L2 扩容时,利用 ZKP 的简洁性和可验证性来验证 MPC 委托计算结果的正确性,提高系统的可信赖度。

3. FHE 作为辅助计算层:仅在需要对单个数据源进行极复杂、长时间的隐私计算或模型训练时,考虑利用 FHE 的远程外包能力。

战略建议:MPC 在未来隐私支付基础设施中的核心地位

基于其在过去十年间不断提升的效率,业已证明的商业可行性以及对天然横向扩展架构的支持 ,本报告建议将多方安全计算确定为下一代隐私支付基础设施的关键核心技术。 未来的研发资源应侧重于持续优化 MPC 协议中的通信开销,通过进一步创新协议设计,提升其在大规模,高并发协作场景下的表现,巩固其在隐私计算领域的战略核心地位。

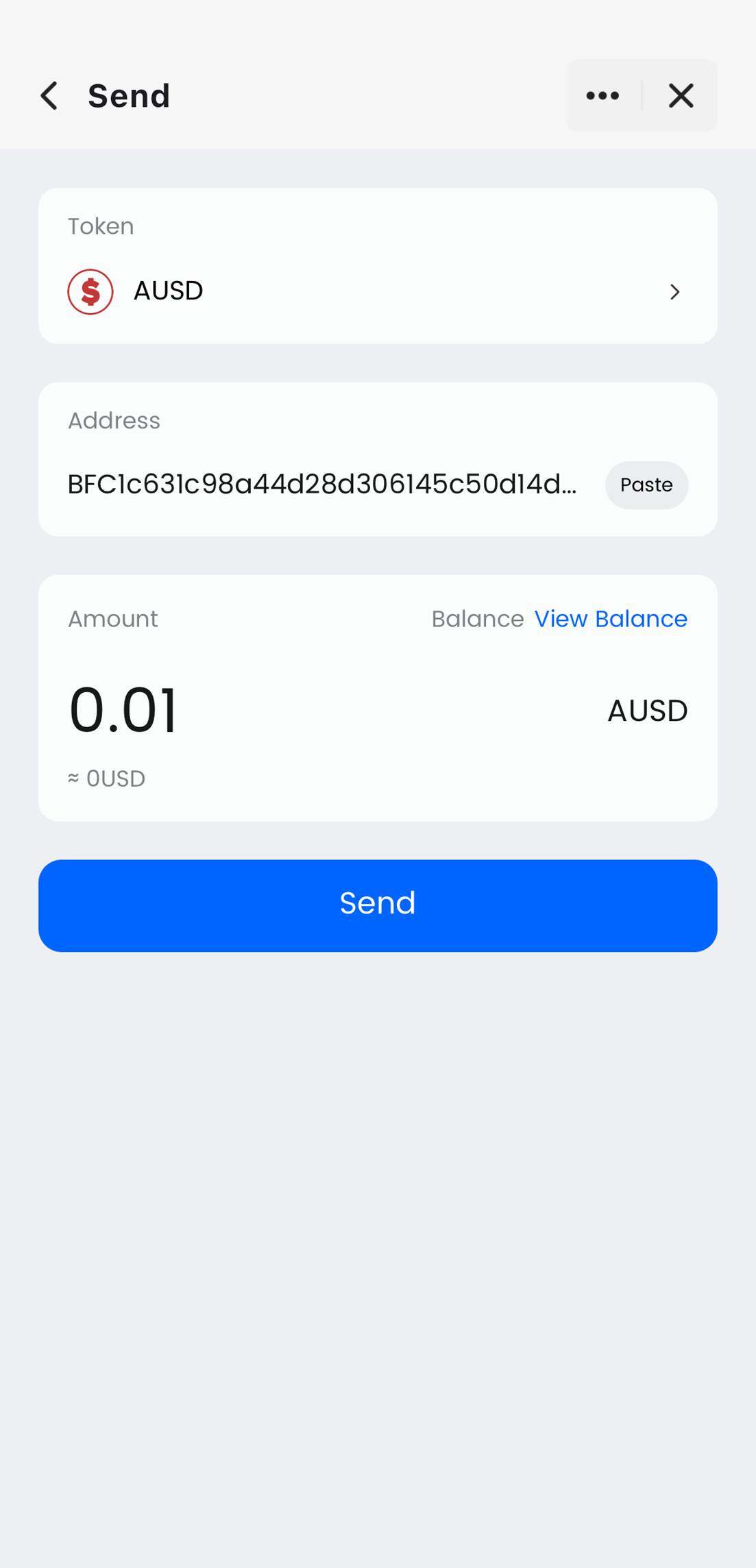

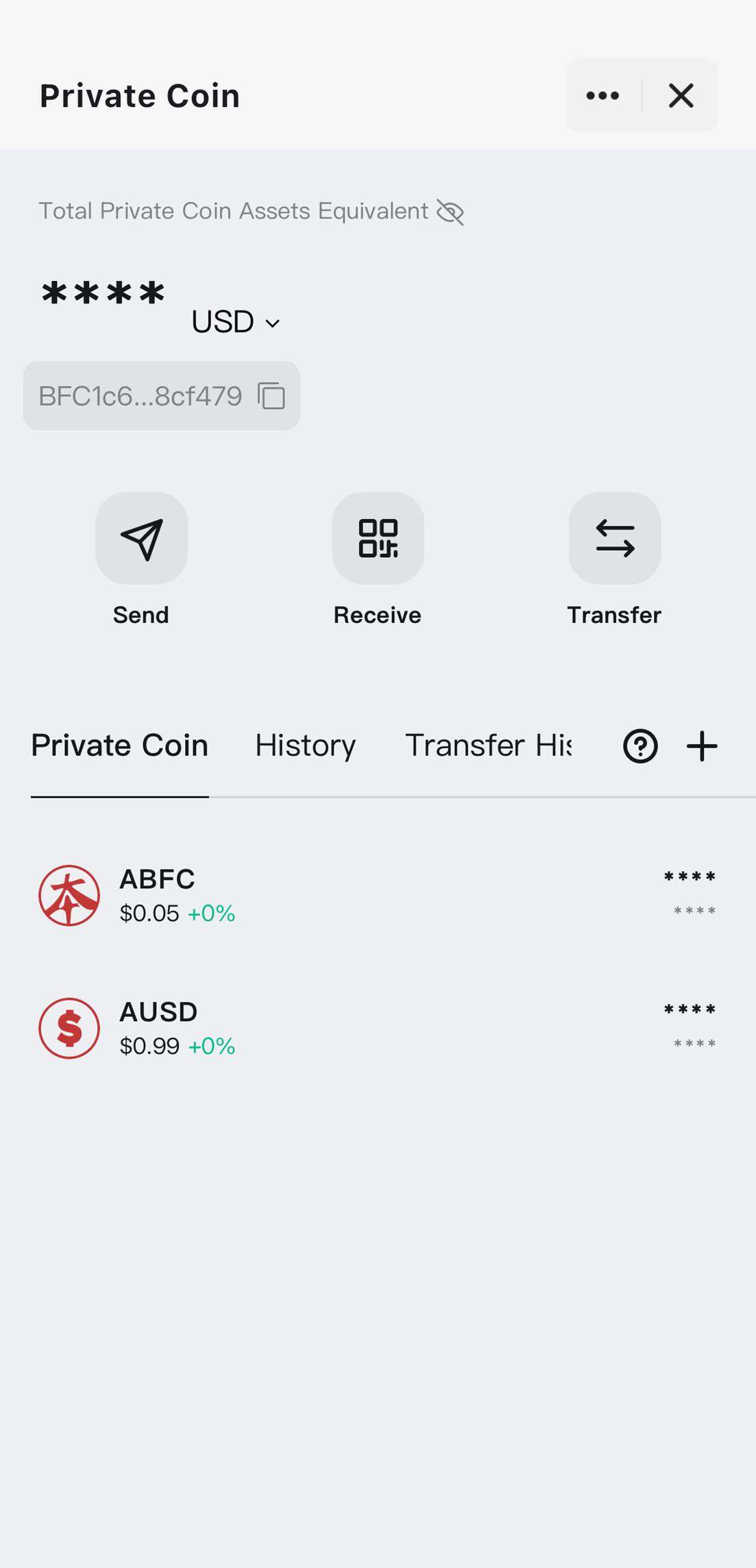

BenFen 隐私支付:MPC 与链上应用结合的实践

在实际应用中,BenFen 公链通过与核心基础设施构建者 State Labs 深度协作,将基于多方安全计算(MPC)的隐私方案原生嵌入链层,提供面向用户和机构的高安全性支付解决方案。BenFen 基于 Move VM 原生支持私密账户与隐私支付,允许用户在链上隐藏交易金额与账户余额,同时结合稳定币支付Gas和赞助交易机制,优化链上操作的便捷性和可用性。

BenFen 的隐私支付与 MPC 技术相辅相成:在多方阈值签名(TSS)框架下,用户资产的密钥份额被拆分并分布在不同节点,任何一方都无法单独恢复完整私钥,交易签署全程无需暴露私钥明文,从源头强化了资产安全性与交易隐私性。依托这一机制,用户的转账路径、交易意图与账户关联性均可在链上被隐私化处理,使稳定币支付、资产互动与频繁交易更不易被监控、分析或画像。未来,BenFen 将进一步推进更去中心化的 SMPC 体系,以提升抗审查能力与故障冗余,为整套隐私支付网络注入更强的稳健性与安全边界。

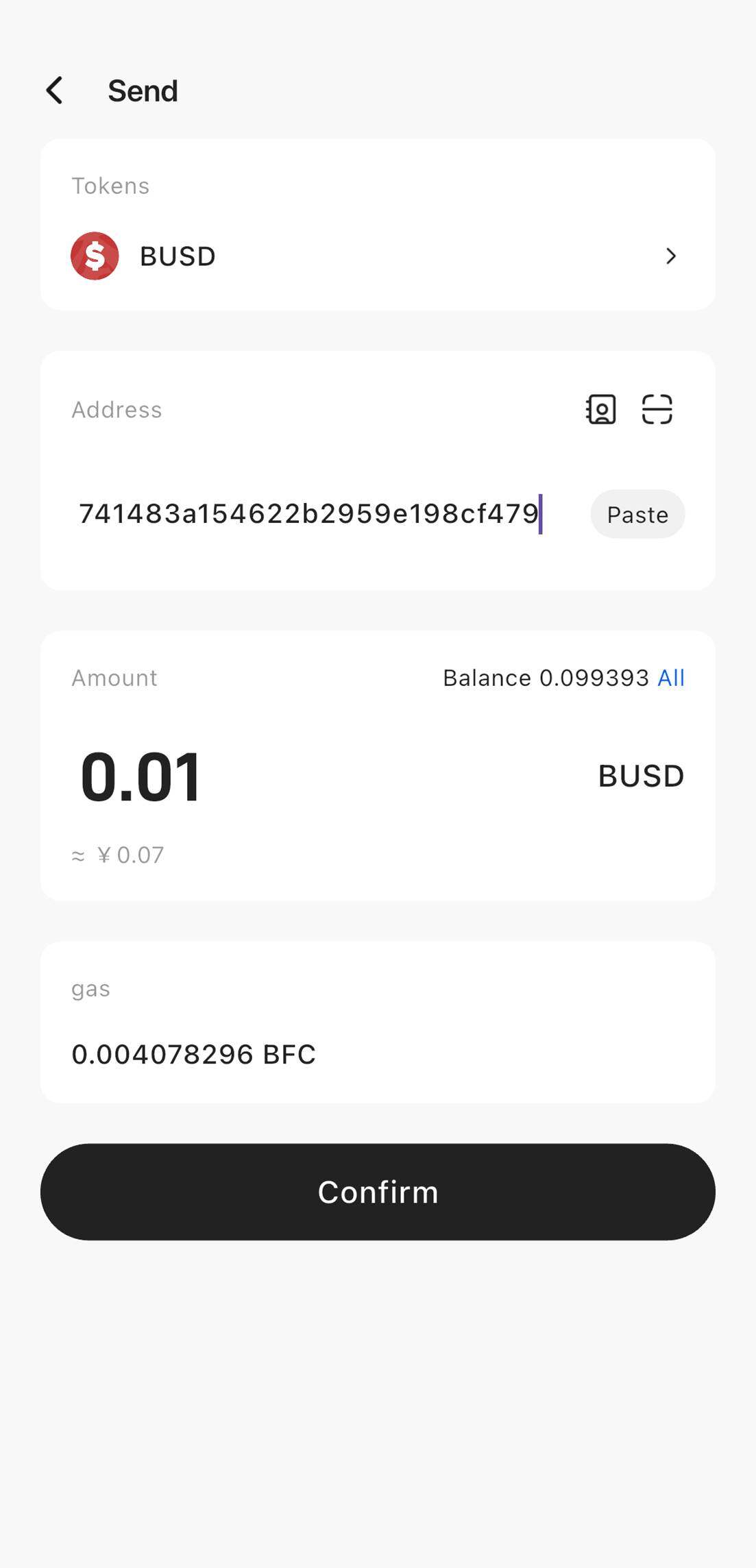

应用层入口 BenPay 则把 BenFen 的隐私支付能力真正带入用户体验层:稳定币可直接用于支付 Gas,使用户在进行 DeFi 赚币、BenPay Card 多链充值与跨境支付、链上转账时,全程保持隐私、无需持有原生代币,并以更熟悉、更低摩擦的方式参与 Web3 金融操作。

在 BenPay DeFi Earn 中,用户的仓位变化与策略调整不暴露给第三方链上分析;在 BenPay Card 中,链上到线下的消费路径被隐私化保护,避免消费轨迹被追踪;在跨链、转账或资产管理过程中,敏感记录不会形成可被识别的明细链路,使链上金融行为具备接近现金支付的安全性与自由度。

在与 State Labs 的协作实践下,不仅为企业级用户带来高性能、高可用与隐私兼得的全新稳定币结算方案,更充分展示了 MPC 在现实场景下的应用潜力,并为下一代隐私支付系统树立了技术标杆。